blogs's People

blogs's Issues

尘归尘,土归土——业务归业务,技术归技术。

随着分布式、微服务的火爆,跨系统的服务调用也变得常见起来。这使得我们在线上追查问题的时候,常常要查阅多个系统的日志。

这时候,问题就出现了。如何确定服务A中的某条日志,对应的是服务B中的一个操作呢?

我们的开发人员提出了一个简单的方案:每次服务调用时,调用方都将一些技术性的数据封装在header中;服务方从header中获取到数据后,记录到日志中(或者做其它必要的操作)。

初版

这个方案的思路无疑是正确的。不过其最初的实现方式么,我实在不敢苟同。因为它要求每次调用服务,都按这个格式来封装数据:

{

"header":{

"traceId":xxxx,// 一次请求的唯一键

"timestampe":zzzz, // 发起 请求的时间戳

"fromSystem":systemA,

"requestId":yyyy, // 业务数据的唯一键

"others":aaaa // 一些其它数据

},

"body":{

// 业务数据

}

} 这个方案的确解决了问题。但是同时它又引入了新的问题。

第一个问题出在requestId字段上。按照方案要求,它应该是业务数据的唯一键,一般就是数据库主键。最主要的问题是,不管用什么样的唯一键,这个字段都应属于业务数据,而非请求头中的技术数据——前者对于业务逻辑往往必不可少,后者则对业务可有可无、为技术上锦上添花。将业务数据放入请求头中,混淆了业务与技术的边界,为后续的变更、扩展带来不小的麻烦。

这套方案中“混淆业务与技术边界”的地方还不止这一处。它将header与body全部放在请求体中——例如http的RequestBody,或JMS的MessageBody中,使得每一段调用服务的业务代码中,都要处理header与body。这次,应当由技术框架承担的功能被写到业务代码中,技术与业务的边界再一次混淆。这次混淆不仅增加了业务代码的代码量和重复率,还导致大量的老代码无法顺利的接入,更为以后的扩展埋下了天坑——如果我们需要统一地再加一个字段怎么办?

说真的,这个方案让我回忆起很久以前在jsp页面上写代码的感觉。HTML标签、CSS样式、数据库事务、业务代码混杂在一起,熬成一锅大杂烩。虽然这样也能够实现业务功能,但是再想改动任何一个点,都难于上青天。

再版

第二套方案中,我们首先去掉了header中的requestId字段。这样,避免了业务代码对技术框架的入侵。

第二步,是避免技术框架入侵业务代码。我们的做法是将header字段放到http的请求头(header)或者JMS消息属性(MessageProperties)中。这样,业务代码仍如以前一样,只需要处理body内的数据。由技术框架提供header的写入和读取功能。这样,通过一些配置(如RestTemplate的拦截器等),就可以把旧代码全部按新规范进行处理。

完成这两步改造后,后续再修改、添加header字段时,只需要对框架代码进行修改即可。

后记

我与身边的开发同事讨论设计原则、设计模式时,常常被投以不理解的眼光:这种东西太理论/理想化了,实践中根本用不上、没必要用、性价比太低。

然而初版方案中,“单一职责”原则被无情的践踏——业务代码背负了技术框架的职责,技术框架也背上了业务代码的包袱。这是其低扩展性问题的根源。

但是,这个观点并没有得到同事们的认同。实际上,再版方案也并没有被通过施行——我们匆匆忙忙的上线了初版方案。

唉……

文件导入基础工具使用说明

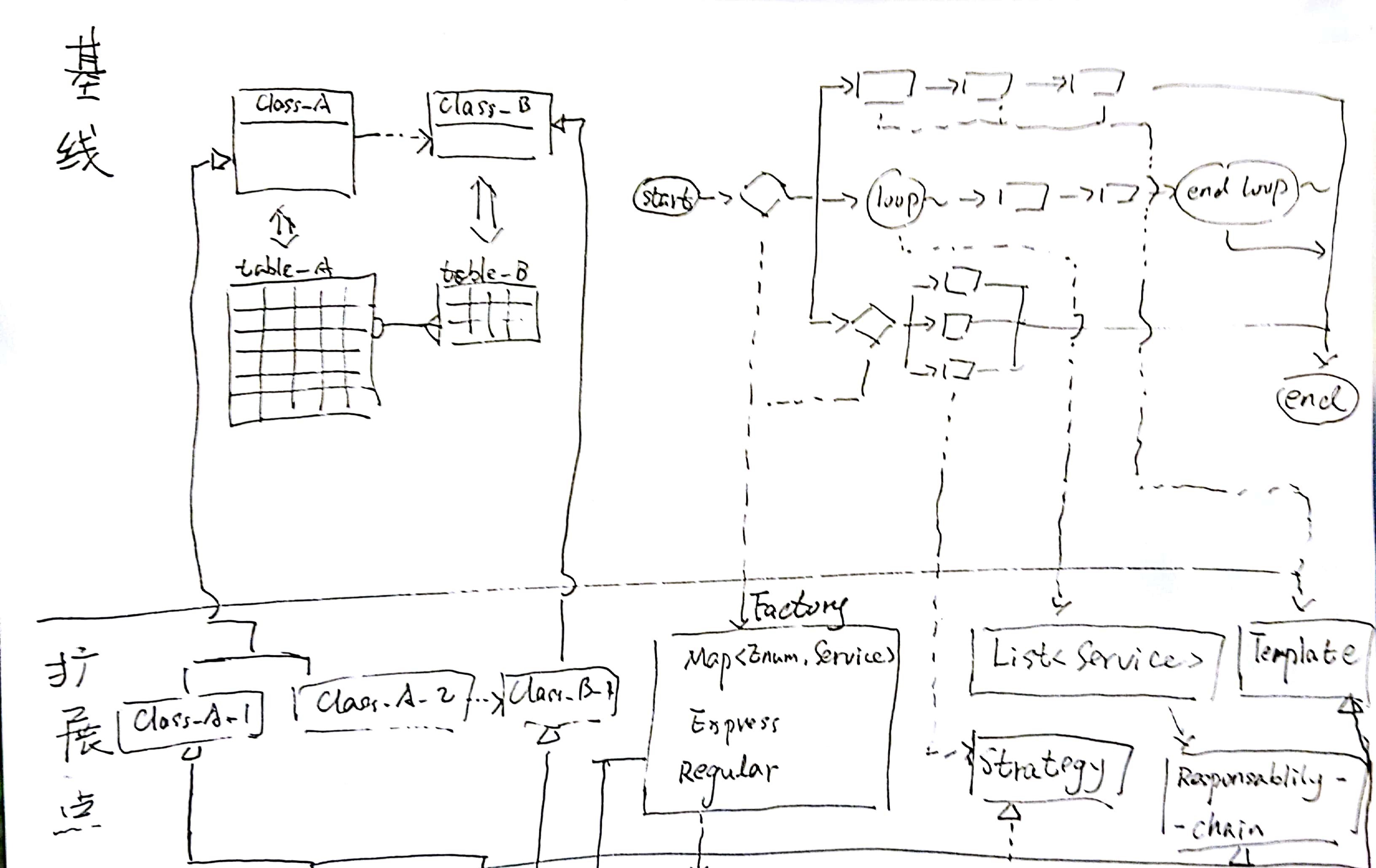

基本思路和目标

把excel文件遍历工作抽取为通用工具,方便大家专注业务逻辑。

把excel数据转换为java对象的工作抽取为通用工具。

为excel数据和java对象的类型转换提供扩展,方便大家根据自己的特定需求进行扩展。

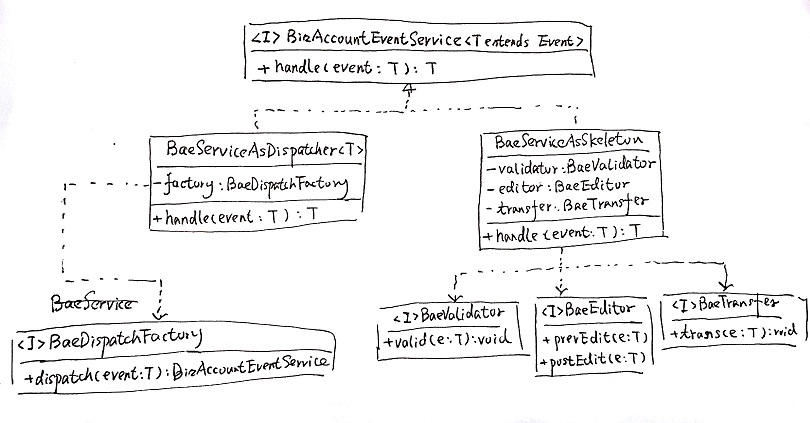

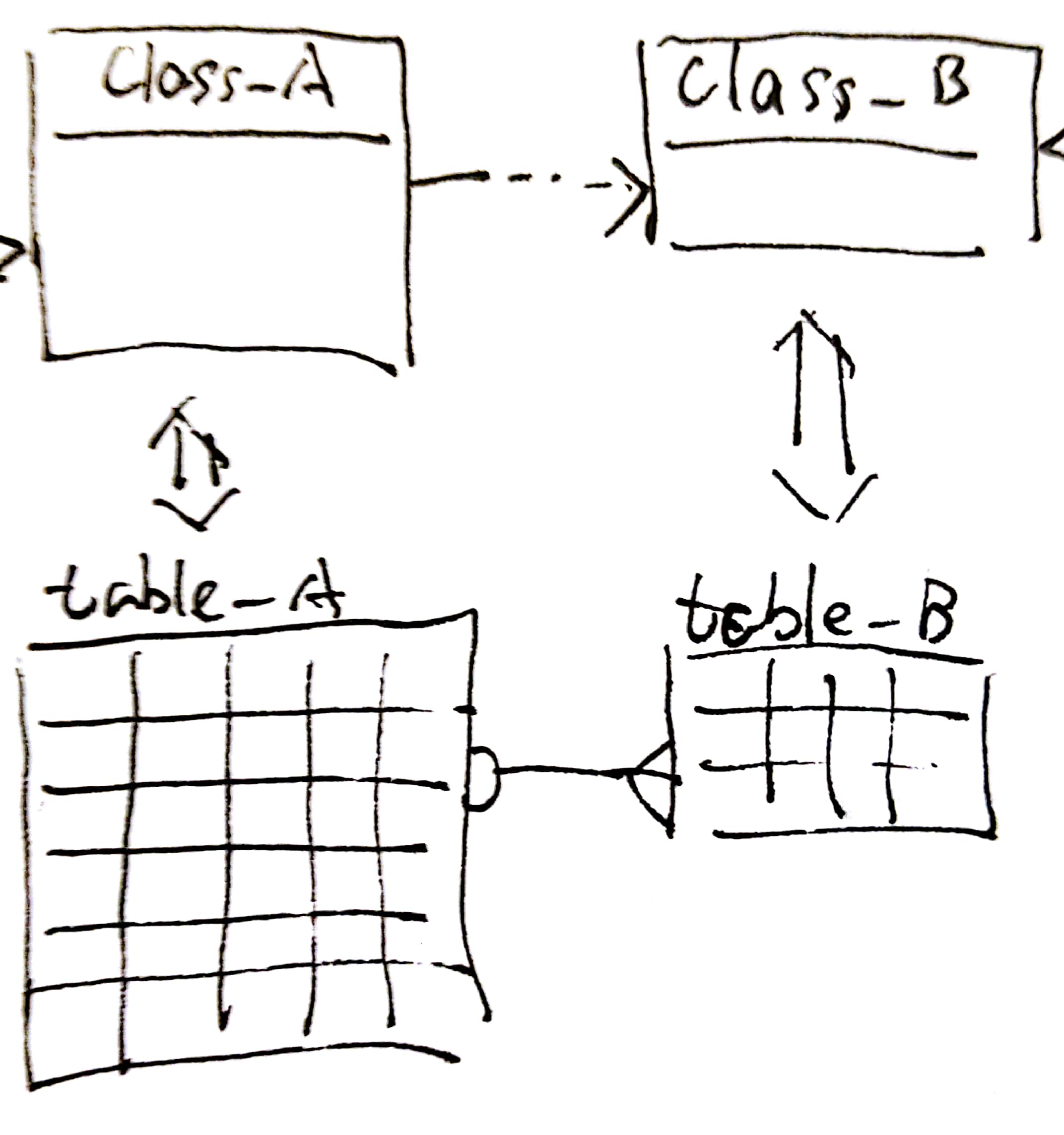

类结构

class diagram

FileImportService.java

FileImportService定义了顶层接口。使用字节数组作为入参有两个考虑。一是导入时的文件类型可能有File、MultipartFile、各种InpurtStream等,用byte[]可以统一接口;二是如果统一用InputStream,可能涉及到谁来关闭流、释放资源的问题。

这个类上声明的泛型类型 T,即文件数据转换后得到的java对象列表。

ImportFromFile.java

ImportFromFile算一个回调接口。在文件导入过程中,如果T实现了这个接口,那么会将importFile()方法参数中的UserInfo 写进对象中。这个接口主要目的是为java对象写入“创建人”属性。

FileImportServiceAsExcel.java

FileImportServiceAsExcel是处理excel文件导入的实现类。除接口方法和setters方法之外的几个方法(loopSheets()、loopRows()、validHeader()、loopCell()、fillField()等),基本都可以顾名思义的明白其含义(分别是遍历excel中的sheet、遍历sheet中的行、校验sheet中的表头各行、遍历一个row中的各个单元格、把单元格中的数据写入对象的字段中)。

需要说明的主要是几个字段的用法。

headerList

headerList是表头校验列表(实质是一个二维数组)。它定义了作为表头的第x行(x即第一维的下标)、第y列(y即第二维的下标)应该是什么名字。如果列表与excel中的名字不匹配,会报错。

例如,假定excel是这样的(可以参见测试类:FileImportServiceAsExcelTest.java):

林俊 29 19861224

那么,headerList就应当是这样:

List<String> headers = new ArrayList<>(2);

headers.add("姓名");

headers.add("年龄");

headers.add("生日");

List<List<String>> headerList = new ArrayList<>(1);

headerList.add(headers);

this.service.setHeaderList(headerList);cellList

cellList是单元格-字段名映射列表。它的下标是excel中单元格的列下标,它的值是对象中的字段名。

例如,假定上面那个excel需要映射到下面这个java类中(同样参见那个测试类):

public class ExcelModel implements ImportFromFile {

private String name;

private Integer age;

private UserInfo creater;

private Date birthday;

// setters && getters

}那么,cellList的定义就应当是:

List<String> cells = new ArrayList<>(2);

cells.add("name");

cells.add("age");

cells.add("birthday");

this.service.setCellList(cells);值得一提的是,cellList中的字段名支持“链式声明”。例如对象中有一个进件并且初始化时new了一个实例,而字段名声明为lendReqeust.id,那么这里是可以把对应单元格中的数值写入这个进件的id字段的。

claz

claz是类的泛型参数T的实际类型。额外定义一个claz的原因,是这里无法根据泛型参数获取实例。因此只能显式的声明一次claz,然后通过Class#getInstance()方法来获得实例。

// 虽然没有尝试过,但是推测,可以将T定义为超类,而将claz声明为子类。

helper是用来将单元格中数据解析为对象字段的帮助类。这个类在后面细说。

ExcelImportHelper.java

ExcelImportHelper是将单元格中数据解析为对象字段的帮助类。它会根据单元格的类型(Cell.getCellType()),和java对象中字段的类型,从transers中找到合适的转换器(CellValueTranser),然后借助转换器来获得数值、并完成设值。

通过这样的映射,可以做到无论单元格是数值类型、文本类型或其它excel类型,只要transers中有定义,都可以正确的转换到字段类型上来。

单元格类型、java对象中字段的类型和转换器之间的映射关系如下:

// cell.getCellType()即单元格类型,是int类型数据

// claz即java对象中字段的类型,这里取其全限定名(包名.类名)

CellValueTransfer transfer = this.transers[cell.getCellType()].get(claz.getName());

在构造方法中,transers被初始化为长度为6的一个数组,并且已经写入了部分转换器(CELL_TYPE_NUMERIC-> Integer/String/Date/BigDecimal,CELL_TYPE_STRING -> Integer/String/Date/BigDecimal等)。

对于当前没有实现的转换器,或者如果需要针对某个类型扩展特定的转换器,我们可以利用ExcelImportHelper中的一系列set方法来实现。以针对CELL_TYPE_NUMERIC的转换器为例:

/**

* 增加CELL_TYPE_NUMERIC的转换器映射

*

* @param transersMap

*/

public void setTransers4Numeric(Map<String, CellValueTransfer> transersMap) {

this.transers[Cell.CELL_TYPE_NUMERIC].putAll(transersMap);

}通过set方法设值以后,会向transers中加入指定的转换器,并用transersMap中的值覆盖transers中key值相同的转换器。

CellValueTranser.java

CellValueTranser接口,及其子类,都是用来完成实际的转换的。默认的转换操作都比较简单。这里不多赘述。

使用方法

首先,定义一个excel导入服务。其中需要声明:claz名称、headerList值和cellList值。

要注意的是:claz必须是类的全名;headerList是一个二维的list;cellList必须与excel的列长相等,如果excel中部分列不需要映射到类字段上,那么cellList中应将它声明为空字符串或者null。

<!-- // linjun 2016-01-08 THREAD-9674 还款日变更,excel导入服务 -->

<bean id="excelImporter4RepaydateChange"

class="********.common.service.system.FileImportServiceAsExcel">

<property name="claz"

value="********.common.model.credit.RepaydateChangeInfo" />

<property name="headerList">

<list>

<bean class="java.util.ArrayList">

<constructor-arg>

<list>

<value>友信交易号</value>

<value>姓名</value>

<value>身份证</value>

<value>人人贷标ID</value>

<value>标状态</value>

<value>导入时间</value>

<value>放标时间</value>

</list>

</constructor-arg>

</bean>

</list>

</property>

<property name="cellList">

<list>

<value>lendRequestId</value>

<value>name</value>

<value></value>

<value></value>

<value></value>

<value></value>

<value>actualLoanDate</value>

</list>

</property>

</bean>待导入的excel如下。其中只有“友信交易号”、“姓名”和“放标时间”这三列需要转换到java对象中。

*友信交易号 姓名 身份证 人人贷标ID 标状态 导入时间 放标时间

*822290 李忠 37068219780824241X 789061 还款中 2015-12-08 17:41:24.0 2015年12月19日

*822289 杨林 320222197906110018 789045 还款中 2015-12-08 17:32:25.0 2015年12月19日

*822288 郁保四 320222197906110018 789045 还款中 2015-12-08 17:32:25.0 2015年12月18日

*822287 扈三娘 320222197906110018 789045 还款中 2015-12-08 17:32:25.0 2015年12月18日

然后,就可以把这个bean注入并使用了。

/**

* 导入excel文件服务

*/

@Resource(name = "excelImporter4RepaydateChange")

private FileImportService<RepaydateChangeInfo> repaydateChangeImporter;

public void importRepaydateChange(MultipartFile file, Principal user)

throws ServiceException {

UserInfo userInfo = new UserInfo(user.getName());

// 将导入的文件转化为java对象

List<RepaydateChangeInfo> infoList = this.parstInfoList(file, userInfo);

// 处理infoList

……

}遗留问题

最主要的问题是,这个处理逻辑中存在“两次遍历”。将文件转换为java对象,是一次遍历;对java对象列表做业务逻辑操作,这又是一次遍历。无论时间、空间上,复杂度都有点高。这是以后的一个优化点。

不做需求复印机——批量操作流程设计

相信每个技术人员都不会甘心做“需求复印机”。

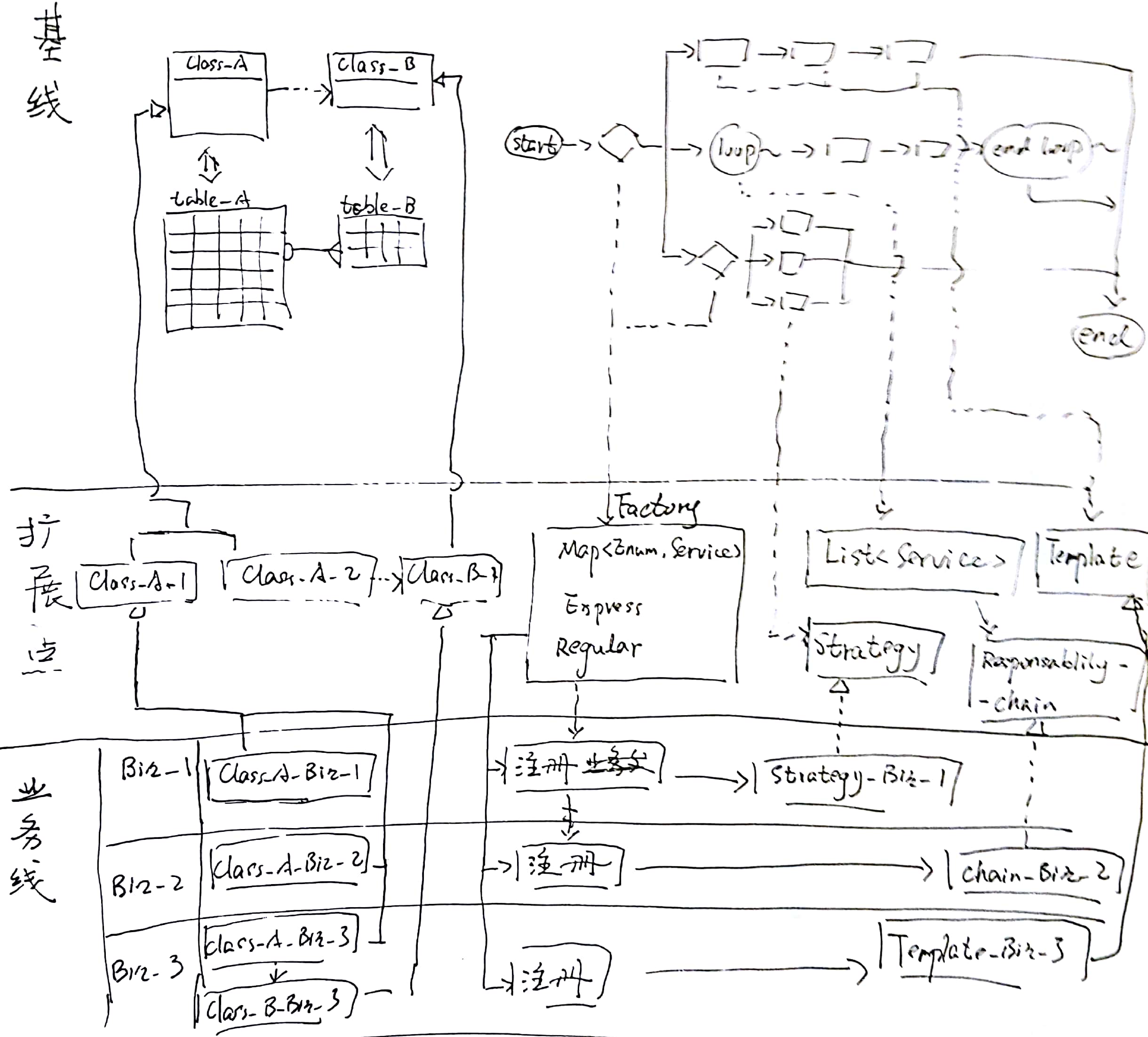

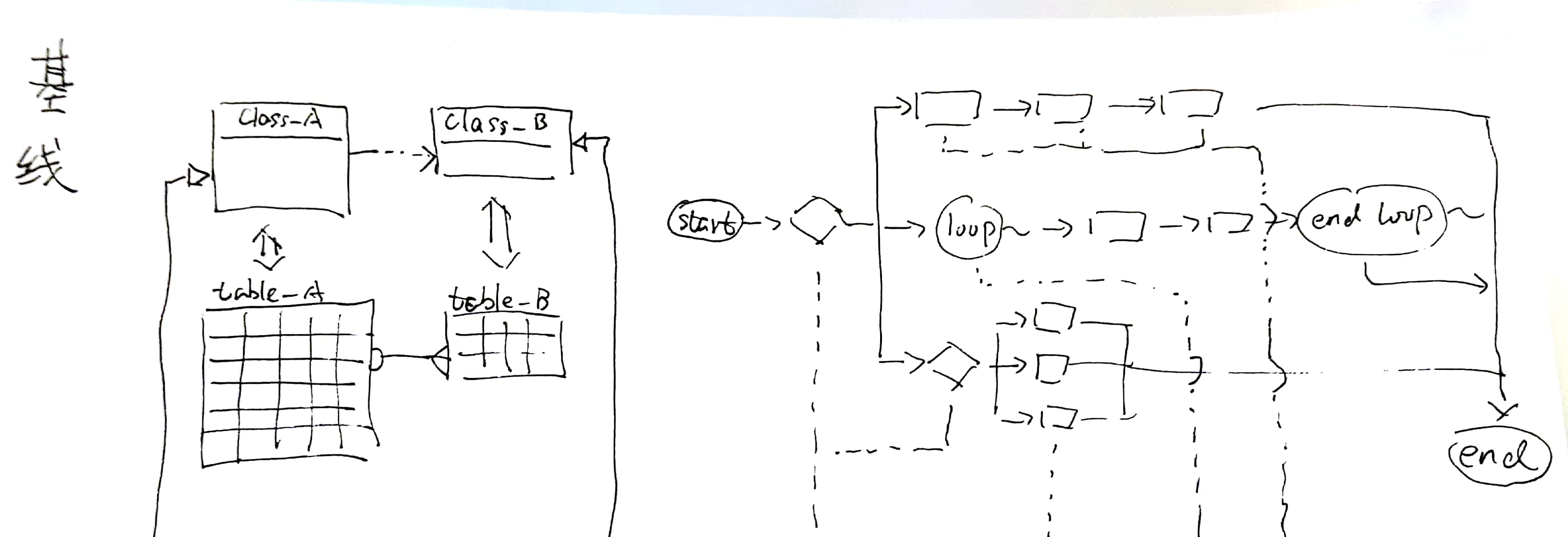

不做需求复印机,有两种简单的方式。一种是在代码/模块/系统的结构上下功夫,例如前面几篇设计方案(审批、分发等)。另一种则是直接对业务流程开刀,例如这篇文章要举的例子。

背景

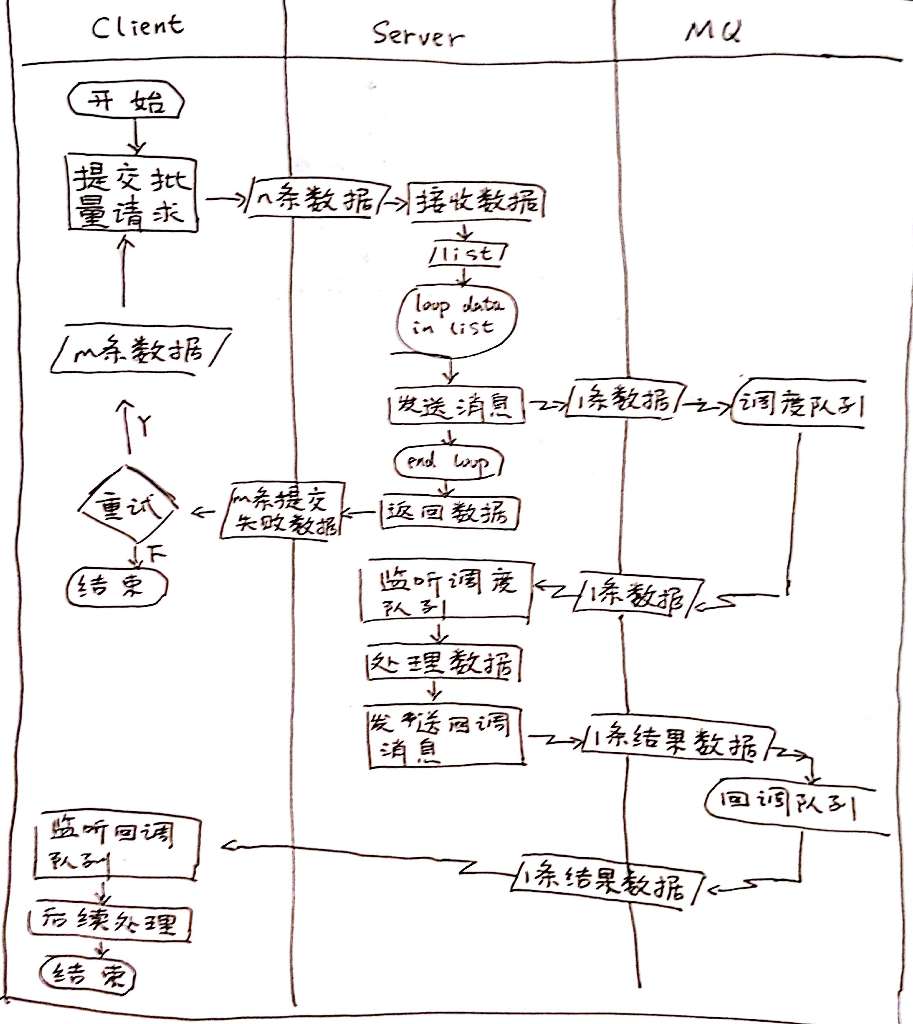

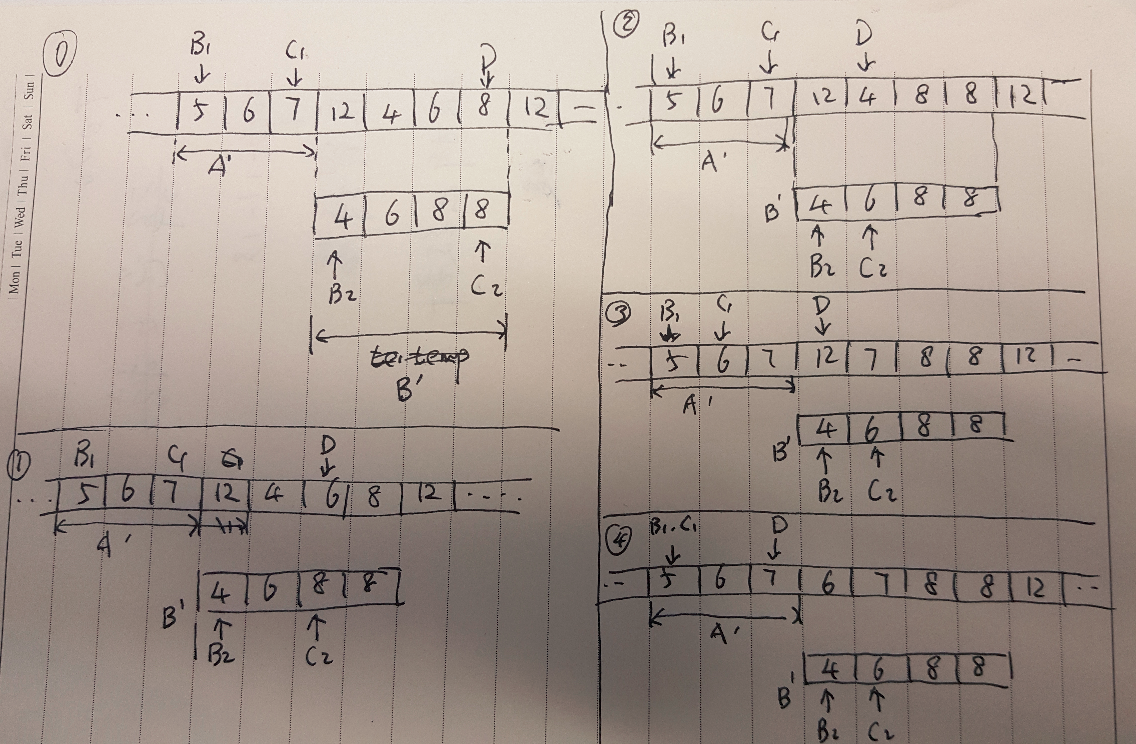

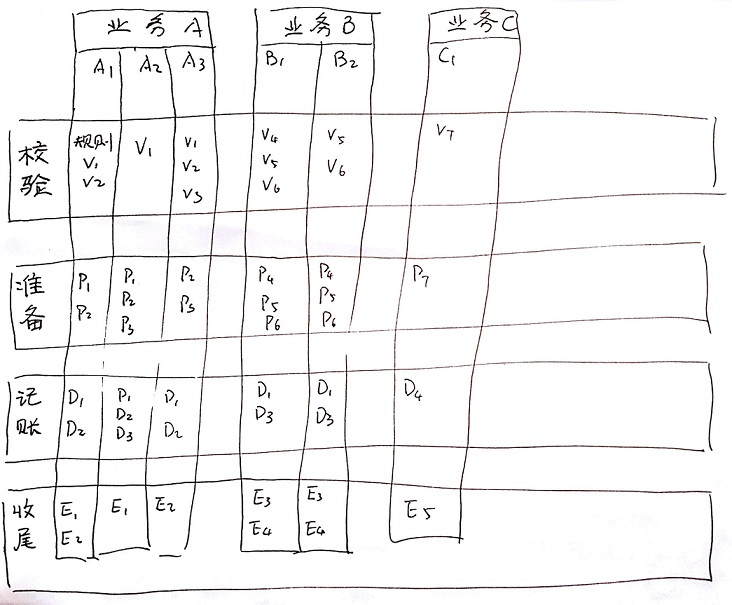

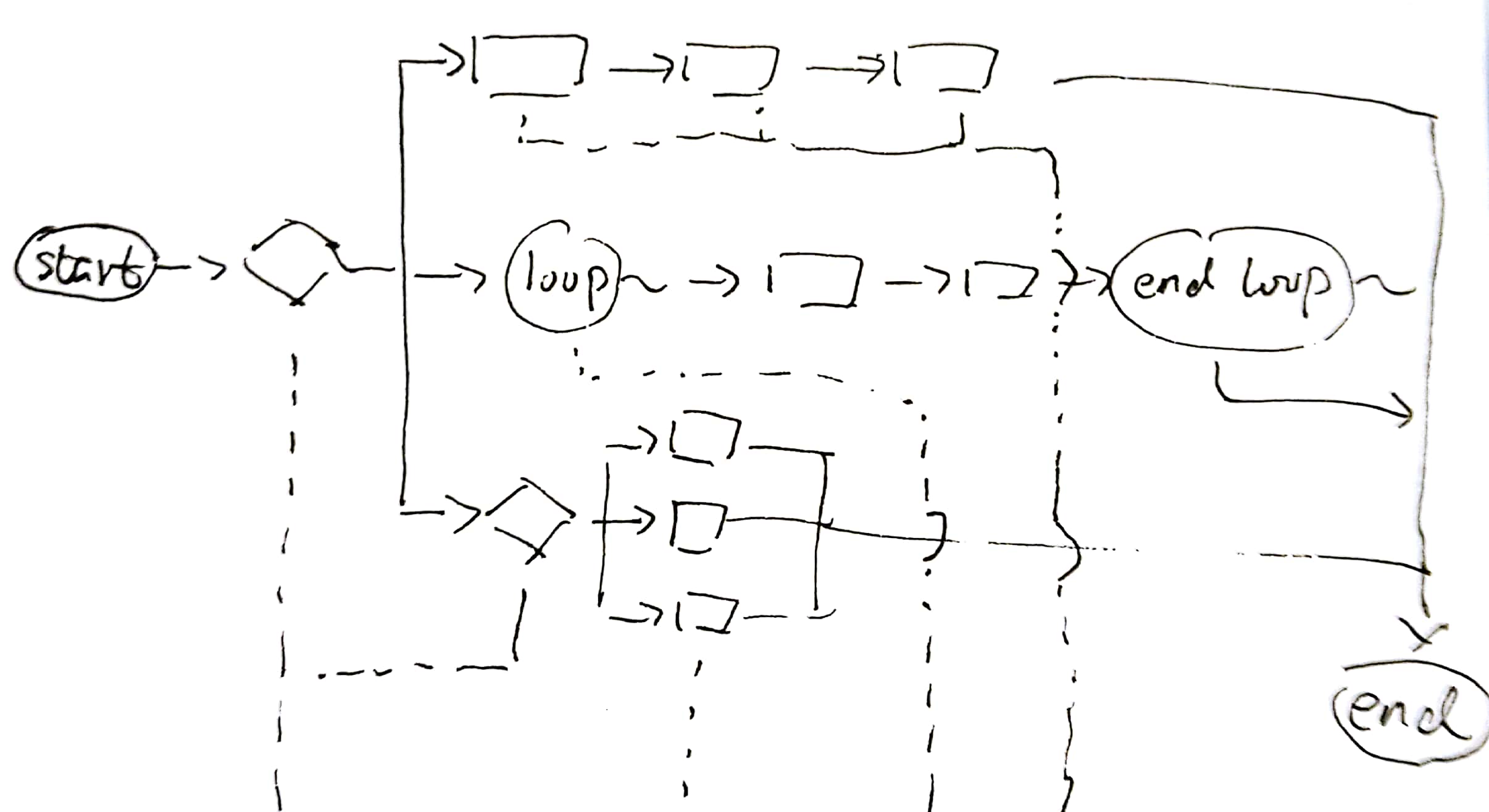

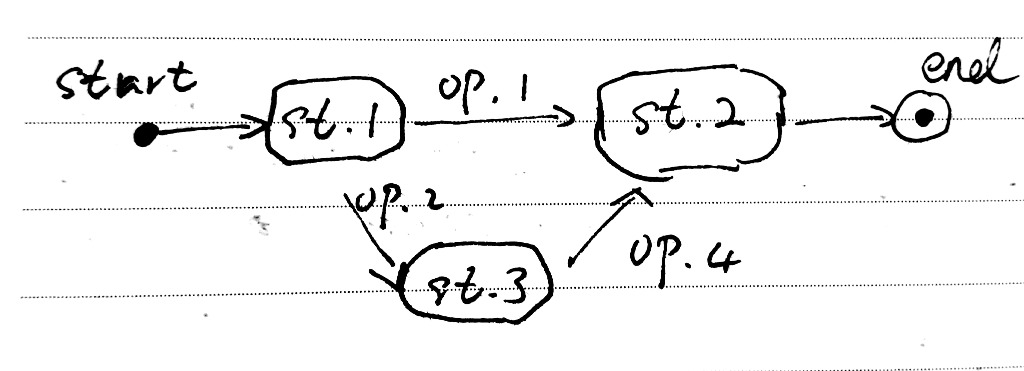

大家一定都遇到过“批处理”这类需求。这次的背景就是一个批处理需求。按产品提出的需求,系统流程是这样的:

如果将这个流程直接“复印”到系统、代码中,显而易见会有性能风险。

思路

这个需求的业务逻辑并不复杂,设计的关注点在于“性能”。性能风险的根源,看起来在于“一次提交N条数据”,实际上在于“同步请求”。因为同步请求会阻塞线程、占用资源,因此它对性能要求比较高。如果不是同步请求,而是异步响应,响应慢点儿其实也无所谓,性能风险自然消弭于无形。因此,我的方案就是用异步回调的方式来完成这个批处理请求。

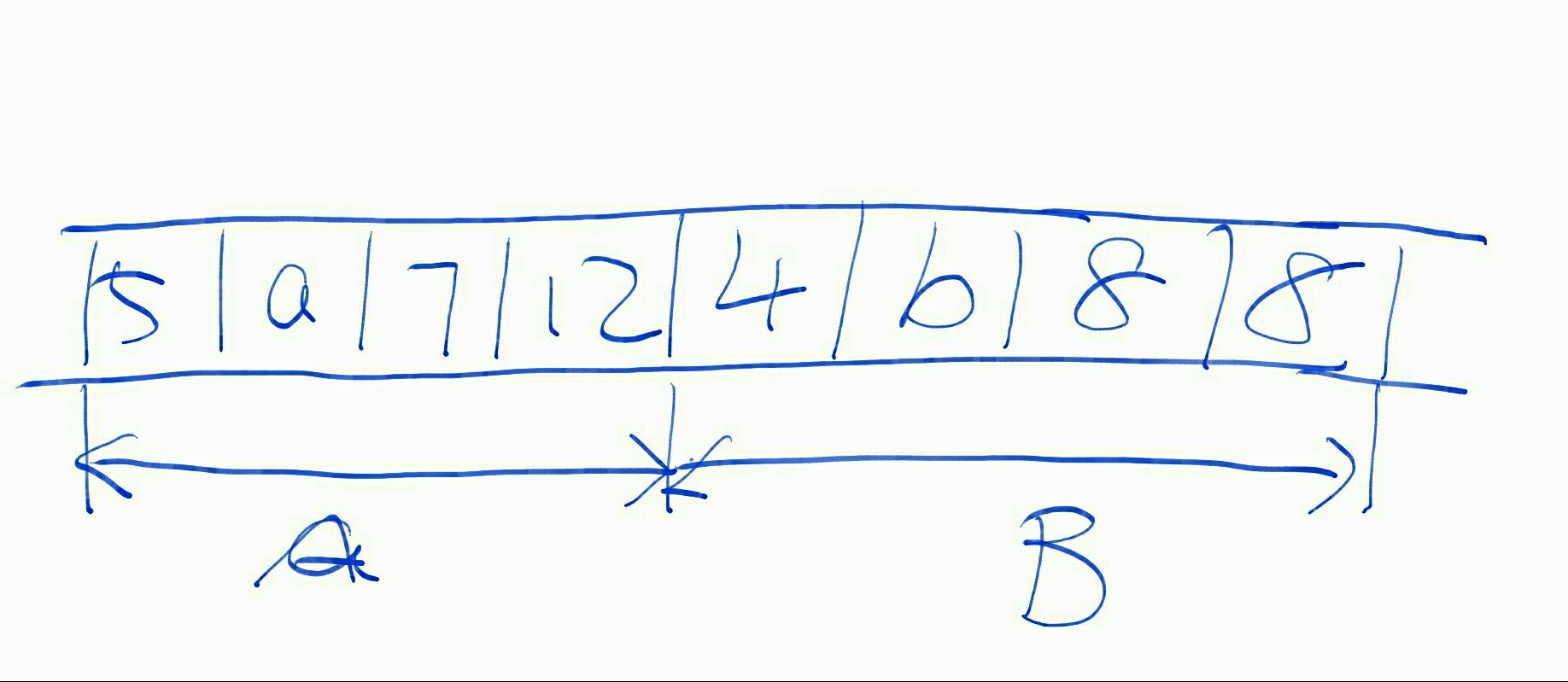

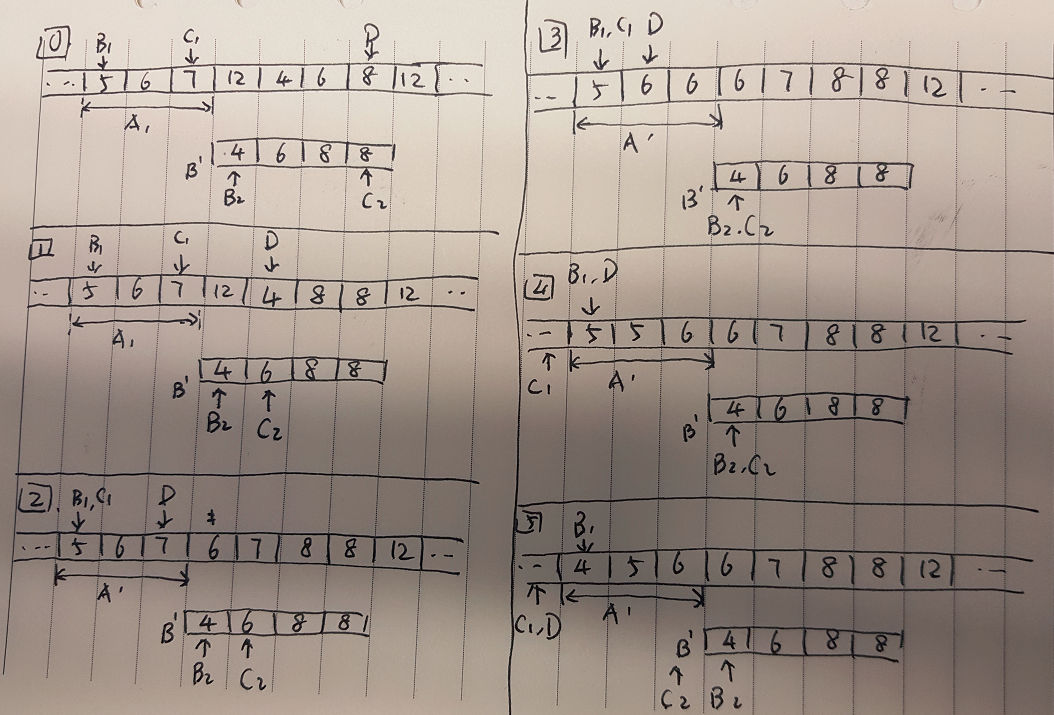

最简单的异步回调流程,就如下图所示。客户端向服务端批量地提交请求;服务端将异步任务提交给调度器后,立刻向客户端返回;然后异步任务再逐个地回调客户端接口,以告知真正的处理结果。

这个简单流程已经足以说明异步回调的思路,其中的问题也显而易见。例如,这个方案中没有对异步任务做持久化、判重、重试、限流的处理。这可能导致任务丢失、调度错误等问题,也可能导致客户端被回调请求压死。

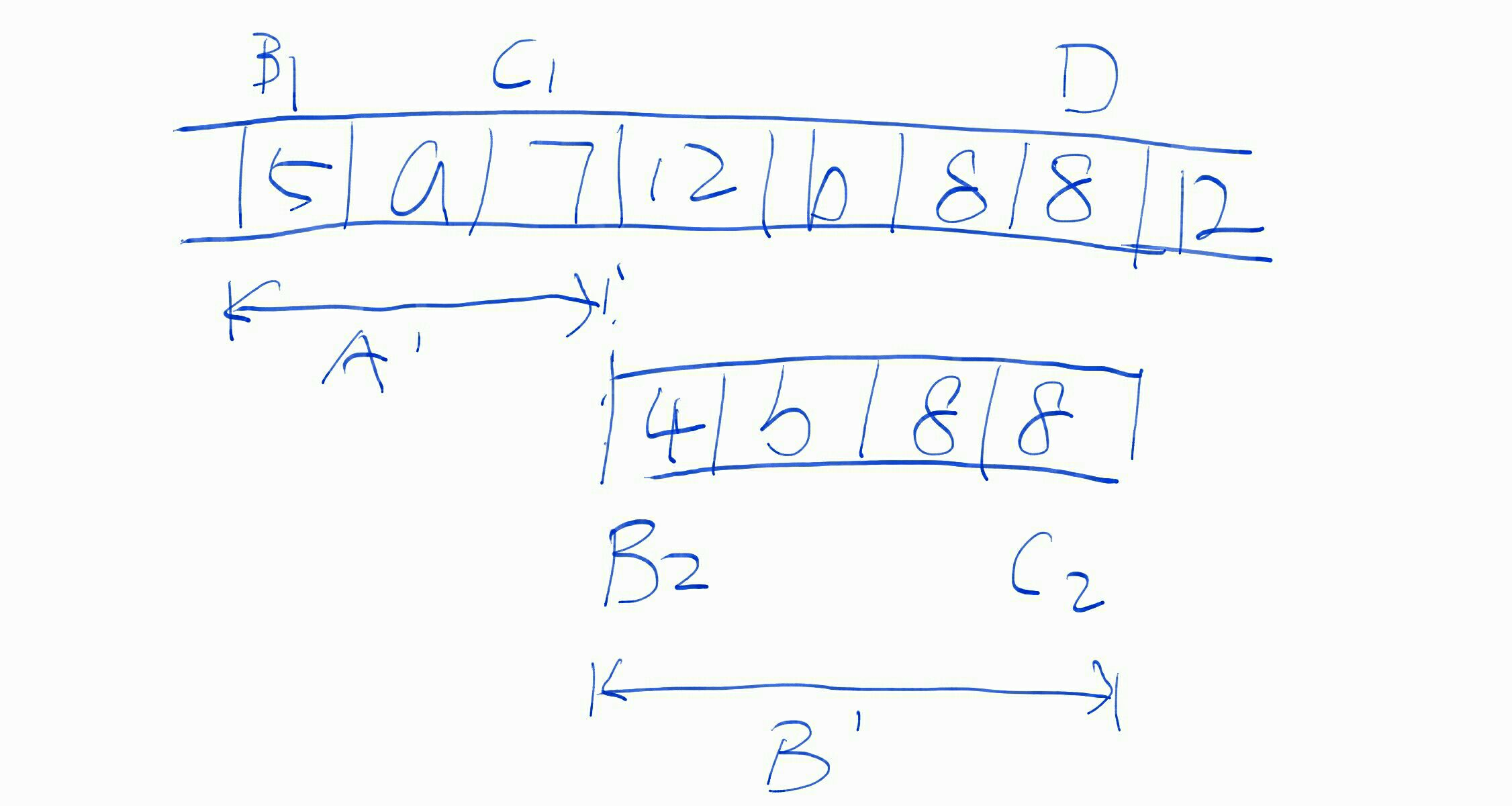

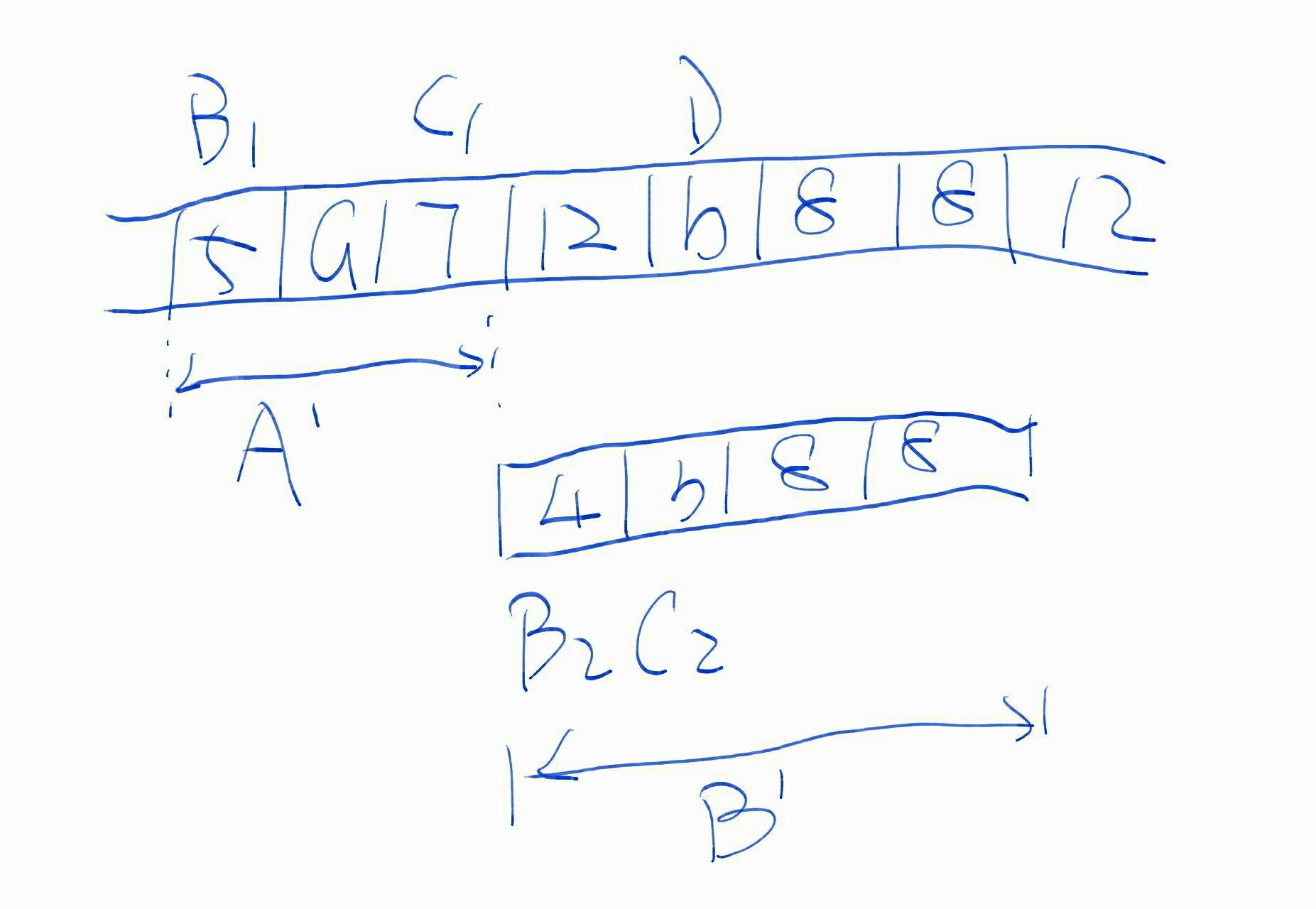

因此,这个简单的异步回调流程中被加入了MQ,即利用消息服务来做异步任务的调度器,并借以解决持久化、重试、限流等问题。如下图所示:

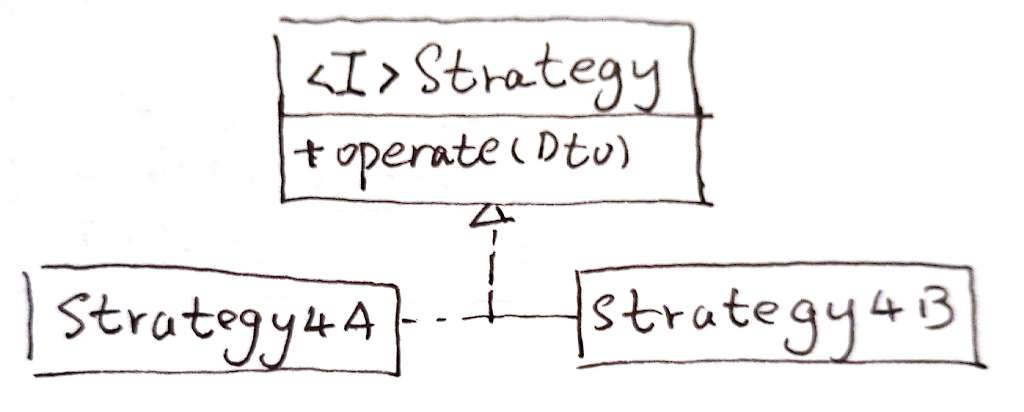

类图与代码

这个方案的设计关键点并不是类结构,而是业务流程。因此,与其它方案的类图、哪怕只是与上面的流程图相比,这次的类图都朴素得多。所以,这次我就偷懒不上类图和代码了。

后记

这个方案其实并不出彩,它的起源只是我不想把产品需求“复印”到代码中而已。但是本质上,它也是一种技术驱动的思路:改变“怎么做”。尽管这个方案还没能进一步地改变“做什么”,但是,改变已从这里开始。

写给大家看的设计书——读后笔记

《写给大家看的设计书》介绍了设计的四个基本原则:亲密性、对齐、重复、对比。作为一个软件“设计师”,我也来聊聊读过这本书之后,我对这四个原则的一点理解。

亲密性

亲密性原则是指:内涵相关联的内容,在结构、关系上也应保持关联。

以软件设计的角度来说,一项业务所包含的功能、一个功能所包含的代码,应该在结构、关系上保持关联。例如把这些代码放到同一个包下、用同一套规则来命名。这样,当我们需要查阅、修改这个功能,需要处理哪些代码就“一望而知”了。

很明显,“亲密性”实际上就是软件工程中常说的“高内聚”。“高内聚”之于软件工程,就如空气之于人一样:重要,却常常被忽视。最常见的一种忽视“高内聚”原则而产生的bad smell,就是不通过继承或组合的方式来新增业务逻辑,而是在原有代码中用if-else/switch-case等方式来扩展。这样一来,新功能的代码就无法放到新功能的“群组”内,进而,在查阅、修改新功能的代码时,无法“一望而知”工作范围、也无法“一望而知”风险范围。

当然,上面的bad smell也可以说是违反了“低耦合”原则导致的。但是必须承认,违反了“高内聚”,则一定会违反“低耦合”。例如,操作Ecxel文件的Service类,却把POI组件泄露到接口之外——这是Excel操作代码不够内聚的缘故;这同时也导致了调用方与POI组件发生耦合,从而违反“低耦合”原则。

“低耦合”可以称为“私密性”原则,不过《写给大家看的设计书》中没有相关论述。这大概是因为,其它领域内的设计是为了充分表达自己的设计目标——要“一望而知”。而软件设计不仅要“一望而知”,还要“一望仅知”。只有这样,才能充分地拆分和管理复杂度。

对齐

“一望而知”各组件的内涵及范围,是“亲密性”原则的优点;而“一望而知”各组件之间的结构、关系,这是“对齐”原则带来的好处。标题对齐,“一望而知”全篇有几个标题;段落对齐,“一望而知”这个标题下有多少个段落。软件设计中会有这样的好事吗?

我有一个很切身的体会,也是一个很好的例子:文件后缀命名。例如,某个接口类命名为AlphaService,那么它的所有子类都在接口名后面缀上说明性单词,以此构成自己的名字。如命名为AlphaServiceAsChain、AlphaServiceAsDispatcher、AlphaService4English、AlphaService4Chinense,诸如此类。这样,由于IDE和操作系统的文件系统、查询功能默认都是字母顺序排列,因而这一系列类在“展示”上就非常紧凑——这就使得它们的关系“一望而知”。

“对齐”规则对现在的软件设计有很大的借鉴意义;规则如果执行得好,软件设计将会获益匪浅。这是因为,现代软件内部的逻辑复杂度一般都非常高。我们要通过设计来降低复杂度,一般只有一种办法:代码功能简单,而关系复杂。上面例子中提到的“接口-实现类”就是一种代码关系,而这种关系可以“一望而知”,这就是“对齐”原则给系统的裨益。

当然,软件中“对齐”的方式还有很多。略牵强一点来讲,同一个接口下的实现类都是向接口“对齐”;同一个模板类下的子类都是向模板“对齐”;符合里氏替换原则的都算“对齐”;等等。

重复

“重复”对其它领域的设计工作来说,也许确实是非常重要的一项原则。运用这项原则,可以把设计意图更加有效地表达出来。

但是,重复无疑是我们软件开发和设计人员最痛恨的:Don't Repeat Yourself! DON'T!!

也许这是软件设计与其它领域设计的一个不同之处。软件设计不仅要考虑表达设计意图,还要管理系统复杂度。“一望仅知”是一种方式,DRY也是同样的考虑。

对比

设计中进行“对比”,一般是为了突出核心设计目的。对软件设计来说,“对比”原则参考意义不大。

后记

最近的技术思考和积累,关注点都不在代码或系统的细节上,而是转向了一些业务系统或逻辑的设计上。这跟我的技术价值观有关:技术的价值是需要体现在业务系统中的。不过这可以另外展开,这里打住。

“设计”行业由来已久,建筑设计、时装设计、包装设计、城市规划设计、工业设计、平面设计……等等等等。这些设计门类都已经积累了很多经验,软件设计能否从中汲取一些营养呢?这也是我开始涉猎《写给大家看的设计书》的原因。

这本书偏“平面”设计——海报、广告、传单等。其设计目标与软件设计有些出入,因此,亲密性、对齐、重复和对比这四个原则,有些确实值得借鉴,有些只能说看看就好。

互联网

暂时关掉

introduction of Fish Eye

中文版参见附件。

THREAD-9175202-261215-1644-20.pdf

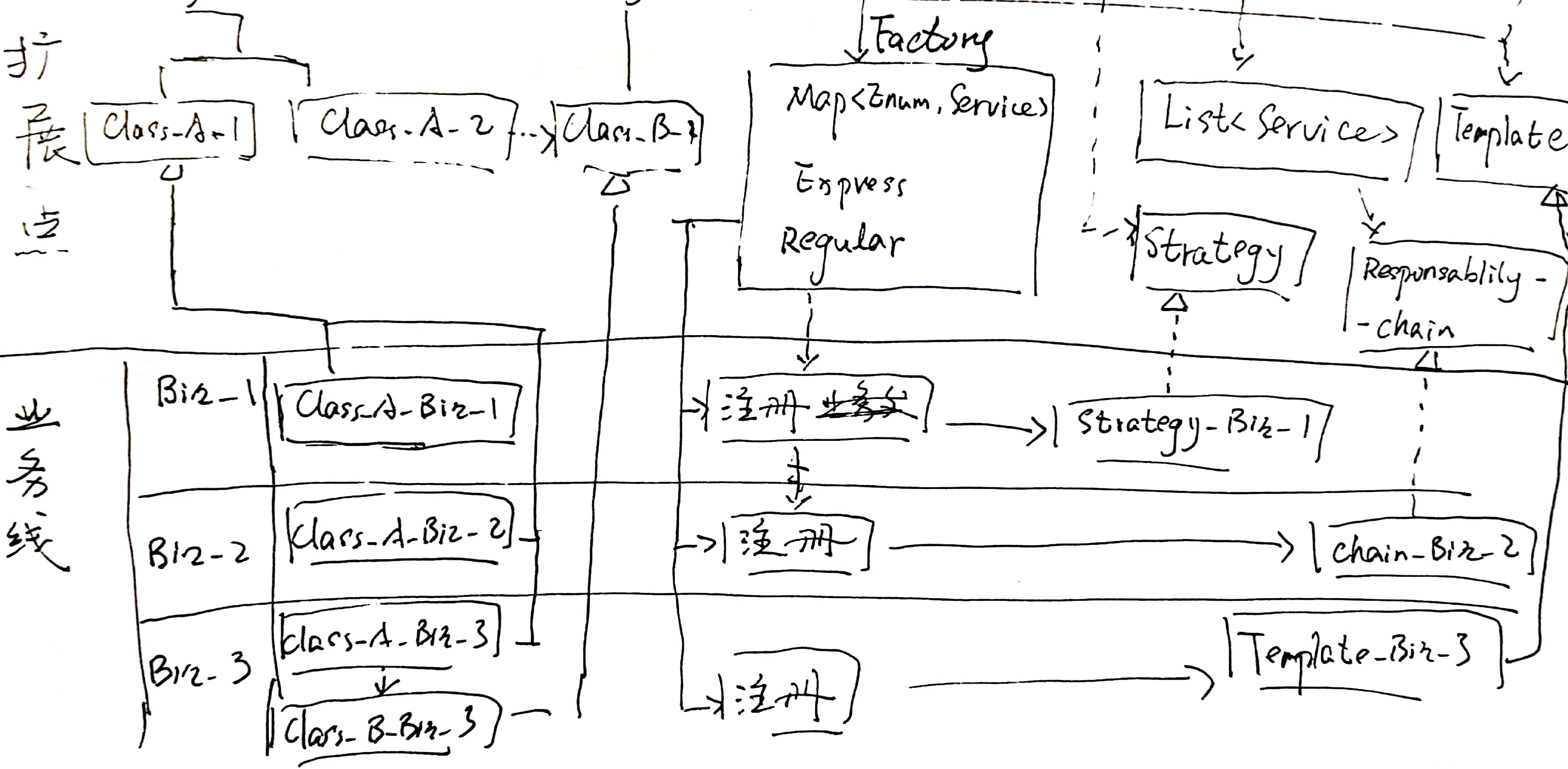

一种在旧代码上增加新需求的重构模式

应用场景

相信大家遇到过这种场景:

旧代码中已经有一堆的if-else或者switch-case了;产品却要求在这段流程里增加一个新的功能。

这种时候大家会怎么做?

我的建议是:

重构这段代码。在重构的基础上,加入新的功能。

肯定会有人说:

工期本来紧张,再对原有代码进行重构,岂不会更加捉襟见肘?

这里介绍的(也是我在实践中经常使用的)这种方式,我称之为“接口-分发器模式”。它可以在尽量减少重构工作量的同时,完成大部分重构工作。

类图

接口

这个模式首先将旧代码/功能抽取为一个接口(ServiceInterface.java)。这个接口的抽象能力,应该能够同时覆盖旧代码中的原有逻辑和新需求中的功能。换句话说就是新、旧代码都可以抽象为同一个接口。

如果这一点都无法做到,建议先回头想想这两段逻辑应不应该放到同一个抽象内。

例如我在一次重构中所做抽取的接口:

public interface RequestApprover {

void approveById(Integer id, Request requestInfo,

UserInfo approver) throws ServiceException;

}这个接口是对请求数据(Request)的审批操作的抽象。

请求数据一共有三类(其中旧类型两种,新需求一种);审批操作同样也有三类(同样,旧类型两种,新需求一种)。这样,最多会有九种审批逻辑(不过实际中只有六种)。而这些审批逻辑和代码,都可以用这一个接口来描述。

分发器

分发器(ServiceDispatcher.java)是服务的入口。但它本身并不提供任何业务服务,而只负责将请求分发给实际的服务处理类。

从这一点上看,分发器其实很像一个工厂。这么说也没错,不过这个分发器的重点在于“分发”,而不是“创建”。

另外,将它隐藏在对外接口之下,是因为我将这个分发器理解为接口的一种实现;它属于抽象之中,不需要被抽象之外的调用者感知。这是我个人偏好。

对应前面的接口,我用到的分发器是这样的。

class RequestApproverAsDispatcher RequestApprover {

private RequestApprover approver4First4NotLate;

private RequestApprover approver4First4PseudoOver;

private RequestApprover approver4Final4NotLate;

private RequestApprover approver4Final4M1;

private RequestApprover approver4Final4PseudoOver;

@Override

public void approveById(Integer id, Request requestInfo,

UserInfo approver) throws ServiceException {

RequestApprover requestApprover;

switch (some_field) {

case FIRST_APPROVED:

case FIRST_REJECTED:

requestApprover = xxx;

break;

case APPROVED:

case REJECTED:

requestApprover = yyy;

break;

default:

throw new UnsupportedOperationException();

}

requestApprover.approveById(id, requestInfo, approver);

}

}具体服务类

具体服务类承担实际上的业务逻辑。在类图中,它们被表示成了Service4Scene1.java ~ Service4Scene7.java。并且,我专门画了ServiceAsAdapter.java和ServiceAsSkeleton.java来表示:这些具体服务类还可以有自己的组织方式、应用自己应用的模式。

在我上面的例子中,我通过一个RequestApproverAsSkeleton.java定义了模板。而在另一项需求中,我用了组合和中介——至少我将那几个类理解为中介模式。

小结

本质上,这个所谓“接口-分发器模式”是一种策略模式。但是它比策略模式多一点东西——分发器。另外,在实践应用中,它不可能只有策略。在“具体服务类”的组织上,几乎都会用上更多的模式。

题外话,就设计模式的应用上,有策略则必有工厂,有工厂几乎必有单例,这似乎也自成一种“模式”。

重构

那么,这个“模式”要怎样应用到重构中呢?

很简单——让旧代码和新代码都成为“具体服务类”中的成员,并且是不同的成员。

仍以上面的例子来说,我将旧代码和新代码分别安排在这两个类中。再结合前面的分发器,很简单的就完成了这次重构,并同时完成了新需求。

class RequestApprover4First extends

RequestApproverAsSkeleton {

private static final Logger LOGGER = LoggerFactory

.getLogger(RequestApprover4First.class);

private RequestService service;

@Override

protected void approve(Request requestInfo,

Request request) throws InvalidDataException {

……

}

@Override

protected void reject(Request requestInfo,

Request request) {

// 不做处理

}

@Override

protected void configRequest(Request requestInfo,

Request request, UserInfo approver) {

……

}

}而新的业务在这个服务中:

class RequestApprover4Check extends

RequestApproverAsSkeleton {

private static final Logger LOGGER = LoggerFactory

.getLogger(RequestApprover4Check.class);

@Override

public void approveById(Integer id, Request requestInfo,

UserInfo approver) throws ServiceException {

……

// 这个方法中有额外处理

}

@Override

protected void approve(Request requestInfo,

Request request) throws ServiceException {

……

}

@Override

protected void reject(Request requestInfo,

Request request) {

// 不做任何操作

}

@Override

protected void configRequest(Request requestInfo,

Request request, UserInfo approver) {

……

}

}优点和缺点

优点应该说比较明显:新、旧逻辑和代码被隔离开了,也就完成了解耦合。并且后续如果还要加新的需求,也可以比较轻松的隔离到新的服务类中。相信接手过旧系统、旧代码的朋友们都能理解其中的意义。

缺点呢?一是容易造成“类爆炸”。虽然不一定变得太多,但是类的数量肯定比不用模式要多。二是这种模式有时候不会(也不需要)对旧代码做任何改动。这样一来,重构目标实际上并没有实现。

最后补充

做重构之前,一定要有用于验证旧代码功能的测试,并且尽可能的覆盖流程分支。

transaction in multi-thread in spring

The transaction introduce in spring.io

http://docs.spring.io/spring/docs/current/spring-framework-reference/htmlsingle/#transaction-intro

- Transaction Management

16.1 Introduction to Spring Framework transaction management

Comprehensive transaction support is among the most compelling reasons to use the Spring Framework. The Spring Framework provides a consistent abstraction for transaction management that delivers the following benefits:

Consistent programming model across different transaction APIs such as Java Transaction API (JTA), JDBC, Hibernate, Java Persistence API (JPA), and Java Data Objects (JDO).

Support for declarative transaction management.

Simpler API for programmatic transaction management than complex transaction APIs such as JTA.

Excellent integration with Spring’s data access abstractions.

The following sections describe the Spring Framework’s transaction value-adds and technologies. (The chapter also includes discussions of best practices, application server integration, and solutions to common problems.)

Advantages of the Spring Framework’s transaction support model describes why you would use the Spring Framework’s transaction abstraction instead of EJB Container-Managed Transactions (CMT) or choosing to drive local transactions through a proprietary API such as Hibernate.

Understanding the Spring Framework transaction abstraction outlines the core classes and describes how to configure and obtain DataSource instances from a variety of sources.

Synchronizing resources with transactionsdescribes how the application code ensures that resources are created, reused, and cleaned up properly.

Declarative transaction management describes support for declarative transaction management.

Programmatic transaction management covers support for programmatic (that is, explicitly coded) transaction management.

Transaction bound event describes how you could use application events within a transaction.

16.2 Advantages of the Spring Framework’s transaction support model

Traditionally, Java EE developers have had two choices for transaction management: global or local transactions, both of which have profound limitations. Global and local transaction management is reviewed in the next two sections, followed by a discussion of how the Spring Framework’s transaction management support addresses the limitations of the global and local transaction models.

16.2.1 Global transactions

Global transactions enable you to work with multiple transactional resources, typically relational databases and message queues. The application server manages global transactions through the JTA, which is a cumbersome API to use (partly due to its exception model). Furthermore, a JTA UserTransaction normally needs to be sourced from JNDI, meaning that you also need to use JNDI in order to use JTA. Obviously the use of global transactions would limit any potential reuse of application code, as JTA is normally only available in an application server environment.

Previously, the preferred way to use global transactions was via EJB CMT (Container Managed Transaction): CMT is a form of declarative transaction management (as distinguished from programmatic transaction management). EJB CMT removes the need for transaction-related JNDI lookups, although of course the use of EJB itself necessitates the use of JNDI. It removes most but not all of the need to write Java code to control transactions. The significant downside is that CMT is tied to JTA and an application server environment. Also, it is only available if one chooses to implement business logic in EJBs, or at least behind a transactional EJB facade. The negatives of EJB in general are so great that this is not an attractive proposition, especially in the face of compelling alternatives for declarative transaction management.

16.2.2 Local transactions

Local transactions are resource-specific, such as a transaction associated with a JDBC connection. Local transactions may be easier to use, but have significant disadvantages: they cannot work across multiple transactional resources. For example, code that manages transactions using a JDBC connection cannot run within a global JTA transaction. Because the application server is not involved in transaction management, it cannot help ensure correctness across multiple resources. (It is worth noting that most applications use a single transaction resource.) Another downside is that local transactions are invasive to the programming model.

16.2.3 Spring Framework’s consistent programming model

Spring resolves the disadvantages of global and local transactions. It enables application developers to use a consistent programming model in any environment. You write your code once, and it can benefit from different transaction management strategies in different environments. The Spring Framework provides both declarative and programmatic transaction management. Most users prefer declarative transaction management, which is recommended in most cases.

With programmatic transaction management, developers work with the Spring Framework transaction abstraction, which can run over any underlying transaction infrastructure. With the preferred declarative model, developers typically write little or no code related to transaction management, and hence do not depend on the Spring Framework transaction API, or any other transaction API.

Do you need an application server for transaction management?

The Spring Framework’s transaction management support changes traditional rules as to when an enterprise Java application requires an application server.

In particular, you do not need an application server simply for declarative transactions through EJBs. In fact, even if your application server has powerful JTA capabilities, you may decide that the Spring Framework’s declarative transactions offer more power and a more productive programming model than EJB CMT.

Typically you need an application server’s JTA capability only if your application needs to handle transactions across multiple resources, which is not a requirement for many applications. Many high-end applications use a single, highly scalable database (such as Oracle RAC) instead. Standalone transaction managers such as Atomikos Transactions and JOTM are other options. Of course, you may need other application server capabilities such as Java Message Service (JMS) and Java EE Connector Architecture (JCA).

The Spring Framework gives you the choice of when to scale your application to a fully loaded application server. Gone are the days when the only alternative to using EJB CMT or JTA was to write code with local transactions such as those on JDBC connections, and face a hefty rework if you need that code to run within global, container-managed transactions. With the Spring Framework, only some of the bean definitions in your configuration file, rather than your code, need to change.

16.3 Understanding the Spring Framework transaction abstraction

The key to the Spring transaction abstraction is the notion of a transaction strategy. A transaction strategy is defined by the org.springframework.transaction.PlatformTransactionManager interface:

public interface PlatformTransactionManager {

TransactionStatus getTransaction(

TransactionDefinition definition) throws TransactionException;

void commit(TransactionStatus status) throws TransactionException;

void rollback(TransactionStatus status) throws TransactionException;

}

This is primarily a service provider interface (SPI), although it can be used programmatically from your application code. Because PlatformTransactionManager is an interface, it can be easily mocked or stubbed as necessary. It is not tied to a lookup strategy such as JNDI. PlatformTransactionManager implementations are defined like any other object (or bean) in the Spring Framework IoC container. This benefit alone makes Spring Framework transactions a worthwhile abstraction even when you work with JTA. Transactional code can be tested much more easily than if it used JTA directly.

Again in keeping with Spring’s philosophy, the TransactionException that can be thrown by any of the PlatformTransactionManager interface’s methods is unchecked (that is, it extends the java.lang.RuntimeException class). Transaction infrastructure failures are almost invariably fatal. In rare cases where application code can actually recover from a transaction failure, the application developer can still choose to catch and handle TransactionException. The salient point is that developers are not forced to do so.

The getTransaction(..) method returns a TransactionStatus object, depending on a TransactionDefinition parameter. The returned TransactionStatus might represent a new transaction, or can represent an existing transaction if a matching transaction exists in the current call stack. The implication in this latter case is that, as with Java EE transaction contexts, a TransactionStatus is associated with a thread of execution.

The TransactionDefinition interface specifies:

Isolation: The degree to which this transaction is isolated from the work of other transactions. For example, can this transaction see uncommitted writes from other transactions?

Propagation: Typically, all code executed within a transaction scope will run in that transaction. However, you have the option of specifying the behavior in the event that a transactional method is executed when a transaction context already exists. For example, code can continue running in the existing transaction (the common case); or the existing transaction can be suspended and a new transaction created. Spring offers all of the transaction propagation options familiar from EJB CMT. To read about the semantics of transaction propagation in Spring, see Section 16.5.7, “Transaction propagation”.

Timeout: How long this transaction runs before timing out and being rolled back automatically by the underlying transaction infrastructure.

Read-only status: A read-only transaction can be used when your code reads but does not modify data. Read-only transactions can be a useful optimization in some cases, such as when you are using Hibernate.

These settings reflect standard transactional concepts. If necessary, refer to resources that discuss transaction isolation levels and other core transaction concepts. Understanding these concepts is essential to using the Spring Framework or any transaction management solution.

The TransactionStatus interface provides a simple way for transactional code to control transaction execution and query transaction status. The concepts should be familiar, as they are common to all transaction APIs:

public interface TransactionStatus extends SavepointManager {

boolean isNewTransaction();

boolean hasSavepoint();

void setRollbackOnly();

boolean isRollbackOnly();

void flush();

boolean isCompleted();

}

Regardless of whether you opt for declarative or programmatic transaction management in Spring, defining the correct PlatformTransactionManager implementation is absolutely essential. You typically define this implementation through dependency injection.

PlatformTransactionManager implementations normally require knowledge of the environment in which they work: JDBC, JTA, Hibernate, and so on. The following examples show how you can define a local PlatformTransactionManager implementation. (This example works with plain JDBC.)

You define a JDBC DataSource

The related PlatformTransactionManager bean definition will then have a reference to the DataSource definition. It will look like this:

If you use JTA in a Java EE container then you use a container DataSource, obtained through JNDI, in conjunction with Spring’s JtaTransactionManager. This is what the JTA and JNDI lookup version would look like:

<jee:jndi-lookup id="dataSource" jndi-name="jdbc/jpetstore"/>

<bean id="txManager" class="org.springframework.transaction.jta.JtaTransactionManager" />

<!-- other <bean/> definitions here -->

The JtaTransactionManager does not need to know about the DataSource, or any other specific resources, because it uses the container’s global transaction management infrastructure.

[Note]

The above definition of the dataSource bean uses the tag from the jee namespace. For more information on schema-based configuration, see Chapter 40, XML Schema-based configuration, and for more information on the tags see the section entitled Section 40.2.3, “the jee schema”.

You can also use Hibernate local transactions easily, as shown in the following examples. In this case, you need to define a Hibernate LocalSessionFactoryBean, which your application code will use to obtain Hibernate Session instances.

The DataSource bean definition will be similar to the local JDBC example shown previously and thus is not shown in the following example.

[Note]

If the DataSource, used by any non-JTA transaction manager, is looked up via JNDI and managed by a Java EE container, then it should be non-transactional because the Spring Framework, rather than the Java EE container, will manage the transactions.

The txManager bean in this case is of the HibernateTransactionManager type. In the same way as the DataSourceTransactionManager needs a reference to the DataSource, the HibernateTransactionManager needs a reference to the SessionFactory.

org/springframework/samples/petclinic/hibernate/petclinic.hbm.xml hibernate.dialect=${hibernate.dialect}If you are using Hibernate and Java EE container-managed JTA transactions, then you should simply use the same JtaTransactionManager as in the previous JTA example for JDBC.

[Note]

If you use JTA , then your transaction manager definition will look the same regardless of what data access technology you use, be it JDBC, Hibernate JPA or any other supported technology. This is due to the fact that JTA transactions are global transactions, which can enlist any transactional resource.

In all these cases, application code does not need to change. You can change how transactions are managed merely by changing configuration, even if that change means moving from local to global transactions or vice versa.

16.4 Synchronizing resources with transactions

It should now be clear how you create different transaction managers, and how they are linked to related resources that need to be synchronized to transactions (for example DataSourceTransactionManager to a JDBC DataSource, HibernateTransactionManager to a Hibernate SessionFactory, and so forth). This section describes how the application code, directly or indirectly using a persistence API such as JDBC, Hibernate, or JDO, ensures that these resources are created, reused, and cleaned up properly. The section also discusses how transaction synchronization is triggered (optionally) through the relevant PlatformTransactionManager.

16.4.1 High-level synchronization approach

The preferred approach is to use Spring’s highest level template based persistence integration APIs or to use native ORM APIs with transaction- aware factory beans or proxies for managing the native resource factories. These transaction-aware solutions internally handle resource creation and reuse, cleanup, optional transaction synchronization of the resources, and exception mapping. Thus user data access code does not have to address these tasks, but can be focused purely on non-boilerplate persistence logic. Generally, you use the native ORM API or take a template approach for JDBC access by using the JdbcTemplate. These solutions are detailed in subsequent chapters of this reference documentation.

16.4.2 Low-level synchronization approach

Classes such as DataSourceUtils (for JDBC), EntityManagerFactoryUtils (for JPA), SessionFactoryUtils (for Hibernate), PersistenceManagerFactoryUtils (for JDO), and so on exist at a lower level. When you want the application code to deal directly with the resource types of the native persistence APIs, you use these classes to ensure that proper Spring Framework-managed instances are obtained, transactions are (optionally) synchronized, and exceptions that occur in the process are properly mapped to a consistent API.

For example, in the case of JDBC, instead of the traditional JDBC approach of calling the getConnection() method on the DataSource, you instead use Spring’s org.springframework.jdbc.datasource.DataSourceUtils class as follows:

Connection conn = DataSourceUtils.getConnection(dataSource);

If an existing transaction already has a connection synchronized (linked) to it, that instance is returned. Otherwise, the method call triggers the creation of a new connection, which is (optionally) synchronized to any existing transaction, and made available for subsequent reuse in that same transaction. As mentioned, any SQLException is wrapped in a Spring Framework CannotGetJdbcConnectionException, one of the Spring Framework’s hierarchy of unchecked DataAccessExceptions. This approach gives you more information than can be obtained easily from the SQLException, and ensures portability across databases, even across different persistence technologies.

This approach also works without Spring transaction management (transaction synchronization is optional), so you can use it whether or not you are using Spring for transaction management.

Of course, once you have used Spring’s JDBC support, JPA support or Hibernate support, you will generally prefer not to use DataSourceUtils or the other helper classes, because you will be much happier working through the Spring abstraction than directly with the relevant APIs. For example, if you use the Spring JdbcTemplate or jdbc.object package to simplify your use of JDBC, correct connection retrieval occurs behind the scenes and you won’t need to write any special code.

16.4.3 TransactionAwareDataSourceProxy

At the very lowest level exists the TransactionAwareDataSourceProxy class. This is a proxy for a target DataSource, which wraps the target DataSource to add awareness of Spring-managed transactions. In this respect, it is similar to a transactional JNDI DataSource as provided by a Java EE server.

It should almost never be necessary or desirable to use this class, except when existing code must be called and passed a standard JDBC DataSource interface implementation. In that case, it is possible that this code is usable, but participating in Spring managed transactions. It is preferable to write your new code by using the higher level abstractions mentioned above.

16.5 Declarative transaction management

[Note]

Most Spring Framework users choose declarative transaction management. This option has the least impact on application code, and hence is most consistent with the ideals of a non-invasive lightweight container.

The Spring Framework’s declarative transaction management is made possible with Spring aspect-oriented programming (AOP), although, as the transactional aspects code comes with the Spring Framework distribution and may be used in a boilerplate fashion, AOP concepts do not generally have to be understood to make effective use of this code.

The Spring Framework’s declarative transaction management is similar to EJB CMT in that you can specify transaction behavior (or lack of it) down to individual method level. It is possible to make a setRollbackOnly() call within a transaction context if necessary. The differences between the two types of transaction management are:

Unlike EJB CMT, which is tied to JTA, the Spring Framework’s declarative transaction management works in any environment. It can work with JTA transactions or local transactions using JDBC, JPA, Hibernate or JDO by simply adjusting the configuration files.

You can apply the Spring Framework declarative transaction management to any class, not merely special classes such as EJBs.

The Spring Framework offers declarative rollback rules,a feature with no EJB equivalent. Both programmatic and declarative support for rollback rules is provided.

The Spring Framework enables you to customize transactional behavior, by using AOP. For example, you can insert custom behavior in the case of transaction rollback. You can also add arbitrary advice, along with the transactional advice. With EJB CMT, you cannot influence the container’s transaction management except with setRollbackOnly().

The Spring Framework does not support propagation of transaction contexts across remote calls, as do high-end application servers. If you need this feature, we recommend that you use EJB. However, consider carefully before using such a feature, because normally, one does not want transactions to span remote calls.

Where is TransactionProxyFactoryBean?

Declarative transaction configuration in versions of Spring 2.0 and above differs considerably from previous versions of Spring. The main difference is that there is no longer any need to configure TransactionProxyFactoryBean beans.

The pre-Spring 2.0 configuration style is still 100% valid configuration; think of the new tx:tags/ as simply defining TransactionProxyFactoryBean beans on your behalf.

The concept of rollback rules is important: they enable you to specify which exceptions (and throwables) should cause automatic rollback. You specify this declaratively, in configuration, not in Java code. So, although you can still call setRollbackOnly() on the TransactionStatus object to roll back the current transaction back, most often you can specify a rule that MyApplicationException must always result in rollback. The significant advantage to this option is that business objects do not depend on the transaction infrastructure. For example, they typically do not need to import Spring transaction APIs or other Spring APIs.

Although EJB container default behavior automatically rolls back the transaction on a system exception (usually a runtime exception), EJB CMT does not roll back the transaction automatically on anapplication exception (that is, a checked exception other than java.rmi.RemoteException). While the Spring default behavior for declarative transaction management follows EJB convention (roll back is automatic only on unchecked exceptions), it is often useful to customize this behavior.

16.5.1 Understanding the Spring Framework’s declarative transaction implementation

It is not sufficient to tell you simply to annotate your classes with the @transactional annotation, add @EnableTransactionManagement to your configuration, and then expect you to understand how it all works. This section explains the inner workings of the Spring Framework’s declarative transaction infrastructure in the event of transaction-related issues.

The most important concepts to grasp with regard to the Spring Framework’s declarative transaction support are that this support is enabled via AOP proxies, and that the transactional advice is driven by metadata (currently XML- or annotation-based). The combination of AOP with transactional metadata yields an AOP proxy that uses a TransactionInterceptor in conjunction with an appropriate PlatformTransactionManager implementation to drive transactions around method invocations.

[Note]

Spring AOP is covered in Chapter 10, Aspect Oriented Programming with Spring.

Conceptually, calling a method on a transactional proxy looks like this…

tx

16.5.2 Example of declarative transaction implementation

Consider the following interface, and its attendant implementation. This example uses Foo and Bar classes as placeholders so that you can concentrate on the transaction usage without focusing on a particular domain model. For the purposes of this example, the fact that the DefaultFooService class throws UnsupportedOperationException instances in the body of each implemented method is good; it allows you to see transactions created and then rolled back in response to the UnsupportedOperationException instance.

// the service interface that we want to make transactional

package x.y.service;

public interface FooService {

Foo getFoo(String fooName);

Foo getFoo(String fooName, String barName);

void insertFoo(Foo foo);

void updateFoo(Foo foo);

}

// an implementation of the above interface

package x.y.service;

public class DefaultFooService implements FooService {

public Foo getFoo(String fooName) {

throw new UnsupportedOperationException();

}

public Foo getFoo(String fooName, String barName) {

throw new UnsupportedOperationException();

}

public void insertFoo(Foo foo) {

throw new UnsupportedOperationException();

}

public void updateFoo(Foo foo) {

throw new UnsupportedOperationException();

}

}

Assume that the first two methods of the FooService interface, getFoo(String) and getFoo(String, String), must execute in the context of a transaction with read-only semantics, and that the other methods, insertFoo(Foo) and updateFoo(Foo), must execute in the context of a transaction with read-write semantics. The following configuration is explained in detail in the next few paragraphs.

<!-- this is the service object that we want to make transactional -->

<bean id="fooService" class="x.y.service.DefaultFooService"/>

<!-- the transactional advice (what 'happens'; see the <aop:advisor/> bean below) -->

<tx:advice id="txAdvice" transaction-manager="txManager">

<!-- the transactional semantics... -->

<tx:attributes>

<!-- all methods starting with 'get' are read-only -->

<tx:method name="get*" read-only="true"/>

<!-- other methods use the default transaction settings (see below) -->

<tx:method name="*"/>

</tx:attributes>

</tx:advice>

<!-- ensure that the above transactional advice runs for any execution

of an operation defined by the FooService interface -->

<aop:config>

<aop:pointcut id="fooServiceOperation" expression="execution(* x.y.service.FooService.*(..))"/>

<aop:advisor advice-ref="txAdvice" pointcut-ref="fooServiceOperation"/>

</aop:config>

<!-- don't forget the DataSource -->

<bean id="dataSource" class="org.apache.commons.dbcp.BasicDataSource" destroy-method="close">

<property name="driverClassName" value="oracle.jdbc.driver.OracleDriver"/>

<property name="url" value="jdbc:oracle:thin:@rj-t42:1521:elvis"/>

<property name="username" value="scott"/>

<property name="password" value="tiger"/>

</bean>

<!-- similarly, don't forget the PlatformTransactionManager -->

<bean id="txManager" class="org.springframework.jdbc.datasource.DataSourceTransactionManager">

<property name="dataSource" ref="dataSource"/>

</bean>

<!-- other <bean/> definitions here -->

Examine the preceding configuration. You want to make a service object, the fooService bean, transactional. The transaction semantics to apply are encapsulated in the tx:advice/ definition. The tx:advice/ definition reads as "… all methods on starting with 'get' are to execute in the context of a read-only transaction, and all other methods are to execute with the default transaction semantics". The transaction-manager attribute of the tx:advice/ tag is set to the name of the PlatformTransactionManager bean that is going to drive the transactions, in this case, the txManager bean.

[Tip]

You can omit the transaction-manager attribute in the transactional advice ( tx:advice/) if the bean name of the PlatformTransactionManager that you want to wire in has the name transactionManager. If the PlatformTransactionManager bean that you want to wire in has any other name, then you must use the transaction-manager attribute explicitly, as in the preceding example.

The aop:config/ definition ensures that the transactional advice defined by the txAdvice bean executes at the appropriate points in the program. First you define a pointcut that matches the execution of any operation defined in the FooService interface ( fooServiceOperation). Then you associate the pointcut with the txAdvice using an advisor. The result indicates that at the execution of a fooServiceOperation, the advice defined by txAdvice will be run.

The expression defined within the aop:pointcut/ element is an AspectJ pointcut expression; see Chapter 10, Aspect Oriented Programming with Spring for more details on pointcut expressions in Spring.

A common requirement is to make an entire service layer transactional. The best way to do this is simply to change the pointcut expression to match any operation in your service layer. For example:

aop:config

<aop:pointcut id="fooServiceMethods" expression="execution(* x.y.service..(..))"/>

<aop:advisor advice-ref="txAdvice" pointcut-ref="fooServiceMethods"/>

/aop:config

[Note]

In this example it is assumed that all your service interfaces are defined in the x.y.service package; see Chapter 10, Aspect Oriented Programming with Spring for more details.

Now that we’ve analyzed the configuration, you may be asking yourself, "Okay… but what does all this configuration actually do?".

The above configuration will be used to create a transactional proxy around the object that is created from the fooService bean definition. The proxy will be configured with the transactional advice, so that when an appropriate method is invoked on the proxy, a transaction is started, suspended, marked as read-only, and so on, depending on the transaction configuration associated with that method. Consider the following program that test drives the above configuration:

public final class Boot {

public static void main(final String[] args) throws Exception {

ApplicationContext ctx = new ClassPathXmlApplicationContext("context.xml", Boot.class);

FooService fooService = (FooService) ctx.getBean("fooService");

fooService.insertFoo (new Foo());

}

}

The output from running the preceding program will resemble the following. (The Log4J output and the stack trace from the UnsupportedOperationException thrown by the insertFoo(..) method of the DefaultFooService class have been truncated for clarity.)

[AspectJInvocationContextExposingAdvisorAutoProxyCreator] - Creating implicit proxy for bean 'fooService' with 0 common interceptors and 1 specific interceptors

[JdkDynamicAopProxy] - Creating JDK dynamic proxy for [x.y.service.DefaultFooService]

[TransactionInterceptor] - Getting transaction for x.y.service.FooService.insertFoo

[DataSourceTransactionManager] - Creating new transaction with name [x.y.service.FooService.insertFoo]

[DataSourceTransactionManager] - Acquired Connection [org.apache.commons.dbcp.PoolableConnection@a53de4] for JDBC transaction

[RuleBasedTransactionAttribute] - Applying rules to determine whether transaction should rollback on java.lang.UnsupportedOperationException

[TransactionInterceptor] - Invoking rollback for transaction on x.y.service.FooService.insertFoo due to throwable [java.lang.UnsupportedOperationException]

[DataSourceTransactionManager] - Rolling back JDBC transaction on Connection [org.apache.commons.dbcp.PoolableConnection@a53de4]

[DataSourceTransactionManager] - Releasing JDBC Connection after transaction

[DataSourceUtils] - Returning JDBC Connection to DataSource

Exception in thread "main" java.lang.UnsupportedOperationException at x.y.service.DefaultFooService.insertFoo(DefaultFooService.java:14)

at $Proxy0.insertFoo(Unknown Source)

at Boot.main(Boot.java:11)

16.5.3 Rolling back a declarative transaction

The previous section outlined the basics of how to specify transactional settings for classes, typically service layer classes, declaratively in your application. This section describes how you can control the rollback of transactions in a simple declarative fashion.

The recommended way to indicate to the Spring Framework’s transaction infrastructure that a transaction’s work is to be rolled back is to throw an Exception from code that is currently executing in the context of a transaction. The Spring Framework’s transaction infrastructure code will catch any unhandled Exception as it bubbles up the call stack, and make a determination whether to mark the transaction for rollback.

In its default configuration, the Spring Framework’s transaction infrastructure code only marks a transaction for rollback in the case of runtime, unchecked exceptions; that is, when the thrown exception is an instance or subclass of RuntimeException. ( Errors will also - by default - result in a rollback). Checked exceptions that are thrown from a transactional method do not result in rollback in the default configuration.

You can configure exactly which Exception types mark a transaction for rollback, including checked exceptions. The following XML snippet demonstrates how you configure rollback for a checked, application-specific Exception type.

<tx:advice id="txAdvice" transaction-manager="txManager">

tx:attributes

<tx:method name="get*" read-only="true" rollback-for="NoProductInStockException"/>

<tx:method name="*"/>

/tx:attributes

/tx:advice

You can also specify 'no rollback rules', if you do not want a transaction rolled back when an exception is thrown. The following example tells the Spring Framework’s transaction infrastructure to commit the attendant transaction even in the face of an unhandled InstrumentNotFoundException.

<tx:advice id="txAdvice">

tx:attributes

<tx:method name="updateStock" no-rollback-for="InstrumentNotFoundException"/>

<tx:method name="*"/>

/tx:attributes

/tx:advice

When the Spring Framework’s transaction infrastructure catches an exception and is consults configured rollback rules to determine whether to mark the transaction for rollback, the strongest matching rule wins. So in the case of the following configuration, any exception other than an InstrumentNotFoundException results in a rollback of the attendant transaction.

<tx:advice id="txAdvice">

tx:attributes

<tx:method name="*" rollback-for="Throwable" no-rollback-for="InstrumentNotFoundException"/>

/tx:attributes

/tx:advice

You can also indicate a required rollback programmatically. Although very simple, this process is quite invasive, and tightly couples your code to the Spring Framework’s transaction infrastructure:

public void resolvePosition() {

try {

// some business logic...

} catch (NoProductInStockException ex) {

// trigger rollback programmatically

TransactionAspectSupport.currentTransactionStatus().setRollbackOnly();

}

}

You are strongly encouraged to use the declarative approach to rollback if at all possible. Programmatic rollback is available should you absolutely need it, but its usage flies in the face of achieving a clean POJO-based architecture.

16.5.4 Configuring different transactional semantics for different beans

Consider the scenario where you have a number of service layer objects, and you want to apply a totally different transactional configuration to each of them. You do this by defining distinct aop:advisor/ elements with differing pointcut and advice-ref attribute values.

As a point of comparison, first assume that all of your service layer classes are defined in a root x.y.service package. To make all beans that are instances of classes defined in that package (or in subpackages) and that have names ending in Service have the default transactional configuration, you would write the following:

<aop:config>

<aop:pointcut id="serviceOperation"

expression="execution(* x.y.service..*Service.*(..))"/>

<aop:advisor pointcut-ref="serviceOperation" advice-ref="txAdvice"/>

</aop:config>

<!-- these two beans will be transactional... -->

<bean id="fooService" class="x.y.service.DefaultFooService"/>

<bean id="barService" class="x.y.service.extras.SimpleBarService"/>

<!-- ... and these two beans won't -->

<bean id="anotherService" class="org.xyz.SomeService"/> <!-- (not in the right package) -->

<bean id="barManager" class="x.y.service.SimpleBarManager"/> <!-- (doesn't end in 'Service') -->

<tx:advice id="txAdvice">

<tx:attributes>

<tx:method name="get*" read-only="true"/>

<tx:method name="*"/>

</tx:attributes>

</tx:advice>

<!-- other transaction infrastructure beans such as a PlatformTransactionManager omitted... -->

The following example shows how to configure two distinct beans with totally different transactional settings.

<aop:config>

<aop:pointcut id="defaultServiceOperation"

expression="execution(* x.y.service.*Service.*(..))"/>

<aop:pointcut id="noTxServiceOperation"

expression="execution(* x.y.service.ddl.DefaultDdlManager.*(..))"/>

<aop:advisor pointcut-ref="defaultServiceOperation" advice-ref="defaultTxAdvice"/>

<aop:advisor pointcut-ref="noTxServiceOperation" advice-ref="noTxAdvice"/>

</aop:config>

<!-- this bean will be transactional (see the 'defaultServiceOperation' pointcut) -->

<bean id="fooService" class="x.y.service.DefaultFooService"/>

<!-- this bean will also be transactional, but with totally different transactional settings -->

<bean id="anotherFooService" class="x.y.service.ddl.DefaultDdlManager"/>

<tx:advice id="defaultTxAdvice">

<tx:attributes>

<tx:method name="get*" read-only="true"/>

<tx:method name="*"/>

</tx:attributes>

</tx:advice>

<tx:advice id="noTxAdvice">

<tx:attributes>

<tx:method name="*" propagation="NEVER"/>

</tx:attributes>

</tx:advice>

<!-- other transaction infrastructure beans such as a PlatformTransactionManager omitted... -->

16.5.5 tx:advice/ settings

This section summarizes the various transactional settings that can be specified using the tx:advice/ tag. The default tx:advice/ settings are:

Propagation setting is REQUIRED.

Isolation level is DEFAULT.

Transaction is read/write.

Transaction timeout defaults to the default timeout of the underlying transaction system, or none if timeouts are not supported.

Any RuntimeException triggers rollback, and any checked Exception does not.

You can change these default settings; the various attributes of the tx:method/ tags that are nested within tx:advice/ and tx:attributes/ tags are summarized below:

Table 16.1. tx:method/ settings

Attribute Required? Default Description

name

Yes

Method name(s) with which the transaction attributes are to be associated. The wildcard () character can be used to associate the same transaction attribute settings with a number of methods; for example, get, handle_, on_Event, and so forth.

propagation

No

REQUIRED

Transaction propagation behavior.

isolation

No

DEFAULT

Transaction isolation level.

timeout

No

-1

Transaction timeout value (in seconds).

read-only

No

false

Is this transaction read-only?

rollback-for

No

Exception(s) that trigger rollback; comma-delimited. For example, com.foo.MyBusinessException,ServletException.

no-rollback-for

No

Exception(s) that do not trigger rollback; comma-delimited. For example, com.foo.MyBusinessException,ServletException.

16.5.6 Using @transactional

In addition to the XML-based declarative approach to transaction configuration, you can use an annotation-based approach. Declaring transaction semantics directly in the Java source code puts the declarations much closer to the affected code. There is not much danger of undue coupling, because code that is meant to be used transactionally is almost always deployed that way anyway.

[Note]

The standard javax.transaction.Transactional annotation is also supported as a drop-in replacement to Spring’s own annotation. Please refer to JTA 1.2 documentation for more details.

The ease-of-use afforded by the use of the @transactional annotation is best illustrated with an example, which is explained in the text that follows. Consider the following class definition:

// the service class that we want to make transactional

@transactional

public class DefaultFooService implements FooService {

Foo getFoo(String fooName);

Foo getFoo(String fooName, String barName);

void insertFoo(Foo foo);

void updateFoo(Foo foo);

}

When the above POJO is defined as a bean in a Spring IoC container, the bean instance can be made transactional by adding merely one line of XML configuration:

<!-- this is the service object that we want to make transactional -->

<bean id="fooService" class="x.y.service.DefaultFooService"/>

<!-- enable the configuration of transactional behavior based on annotations -->

<tx:annotation-driven transaction-manager="txManager"/><!-- a PlatformTransactionManager is still required -->

<bean id="txManager" class="org.springframework.jdbc.datasource.DataSourceTransactionManager">

<!-- (this dependency is defined somewhere else) -->

<property name="dataSource" ref="dataSource"/>

</bean>

<!-- other <bean/> definitions here -->

[Tip]

You can omit the transaction-manager attribute in the tx:annotation-driven/ tag if the bean name of the PlatformTransactionManager that you want to wire in has the name transactionManager. If the PlatformTransactionManager bean that you want to dependency-inject has any other name, then you have to use the transaction-manager attribute explicitly, as in the preceding example.

[Note]

The @EnableTransactionManagement annotation provides equivalent support if you are using Java based configuration. Simply add the annotation to a @configuration class. See the javadocs for full details.

Method visibility and @transactional

When using proxies, you should apply the @transactional annotation only to methods with public visibility. If you do annotate protected, private or package-visible methods with the @transactional annotation, no error is raised, but the annotated method does not exhibit the configured transactional settings. Consider the use of AspectJ (see below) if you need to annotate non-public methods.

You can place the @transactional annotation before an interface definition, a method on an interface, a class definition, or a public method on a class. However, the mere presence of the @transactional annotation is not enough to activate the transactional behavior. The @transactional annotation is simply metadata that can be consumed by some runtime infrastructure that is @Transactional-aware and that can use the metadata to configure the appropriate beans with transactional behavior. In the preceding example, the tx:annotation-driven/ element switches on the transactional behavior.

[Tip]

Spring recommends that you only annotate concrete classes (and methods of concrete classes) with the @transactional annotation, as opposed to annotating interfaces. You certainly can place the @transactional annotation on an interface (or an interface method), but this works only as you would expect it to if you are using interface-based proxies. The fact that Java annotations are not inherited from interfaces means that if you are using class-based proxies ( proxy-target-class="true") or the weaving-based aspect ( mode="aspectj"), then the transaction settings are not recognized by the proxying and weaving infrastructure, and the object will not be wrapped in a transactional proxy, which would be decidedly bad.

[Note]

In proxy mode (which is the default), only external method calls coming in through the proxy are intercepted. This means that self-invocation, in effect, a method within the target object calling another method of the target object, will not lead to an actual transaction at runtime even if the invoked method is marked with @transactional. Also, the proxy must be fully initialized to provide the expected behaviour so you should not rely on this feature in your initialization code, i.e. @PostConstruct.

Consider the use of AspectJ mode (see mode attribute in table below) if you expect self-invocations to be wrapped with transactions as well. In this case, there will not be a proxy in the first place; instead, the target class will be weaved (that is, its byte code will be modified) in order to turn @transactional into runtime behavior on any kind of method.

Table 16.2. Annotation driven transaction settings

XML Attribute Annotation Attribute Default Description

transaction-manager

N/A (See TransactionManagementConfigurer javadocs)

transactionManager

Name of transaction manager to use. Only required if the name of the transaction manager is not transactionManager, as in the example above.

mode

mode

proxy

The default mode "proxy" processes annotated beans to be proxied using Spring’s AOP framework (following proxy semantics, as discussed above, applying to method calls coming in through the proxy only). The alternative mode "aspectj" instead weaves the affected classes with Spring’s AspectJ transaction aspect, modifying the target class byte code to apply to any kind of method call. AspectJ weaving requires spring-aspects.jar in the classpath as well as load-time weaving (or compile-time weaving) enabled. (See the section called “Spring configuration” for details on how to set up load-time weaving.)

proxy-target-class

proxyTargetClass

false

Applies to proxy mode only. Controls what type of transactional proxies are created for classes annotated with the @transactional annotation. If the proxy-target-class attribute is set to true, then class-based proxies are created. If proxy-target-class is false or if the attribute is omitted, then standard JDK interface-based proxies are created. (See Section 10.6, “Proxying mechanisms” for a detailed examination of the different proxy types.)

order

order

Ordered.LOWEST_PRECEDENCE

Defines the order of the transaction advice that is applied to beans annotated with @transactional. (For more information about the rules related to ordering of AOP advice, see the section called “Advice ordering”.) No specified ordering means that the AOP subsystem determines the order of the advice.

[Note]

The proxy-target-class attribute controls what type of transactional proxies are created for classes annotated with the @transactional annotation. If proxy-target-class is set to true, class-based proxies are created. If proxy-target-class is false or if the attribute is omitted, standard JDK interface-based proxies are created. (See Section 10.6, “Proxying mechanisms” for a discussion of the different proxy types.)

[Note]

@EnableTransactionManagement and tx:annotation-driven/ only looks for @transactional on beans in the same application context they are defined in. This means that, if you put annotation driven configuration in a WebApplicationContext for a DispatcherServlet, it only checks for @transactional beans in your controllers, and not your services. See Section 21.2, “The DispatcherServlet” for more information.

The most derived location takes precedence when evaluating the transactional settings for a method. In the case of the following example, the DefaultFooService class is annotated at the class level with the settings for a read-only transaction, but the @transactional annotation on the updateFoo(Foo) method in the same class takes precedence over the transactional settings defined at the class level.

@transactional(readOnly = true)

public class DefaultFooService implements FooService {

public Foo getFoo(String fooName) {

// do something

}

// these settings have precedence for this method

@Transactional(readOnly = false, propagation = Propagation.REQUIRES_NEW)

public void updateFoo(Foo foo) {

// do something

}

}

@transactional settings

The @transactional annotation is metadata that specifies that an interface, class, or method must have transactional semantics; for example, "start a brand new read-only transaction when this method is invoked, suspending any existing transaction". The default @transactional settings are as follows:

Propagation setting is PROPAGATION_REQUIRED.

Isolation level is ISOLATION_DEFAULT.

Transaction is read/write.

Transaction timeout defaults to the default timeout of the underlying transaction system, or to none if timeouts are not supported.

Any RuntimeException triggers rollback, and any checked Exception does not.

These default settings can be changed; the various properties of the @transactional annotation are summarized in the following table:

Table 16.3. @

Property Type Description

value

String

Optional qualifier specifying the transaction manager to be used.

propagation

enum: Propagation

Optional propagation setting.

isolation

enum: Isolation

Optional isolation level.

readOnly

boolean

Read/write vs. read-only transaction

timeout

int (in seconds granularity)

Transaction timeout.

rollbackFor

Array of Class objects, which must be derived from Throwable.

Optional array of exception classes that must cause rollback.

rollbackForClassName

Array of class names. Classes must be derived from Throwable.

Optional array of names of exception classes that must cause rollback.

noRollbackFor

Array of Class objects, which must be derived from Throwable.

Optional array of exception classes that must not cause rollback.

noRollbackForClassName

Array of String class names, which must be derived from Throwable.

Optional array of names of exception classes that must not cause rollback.

Currently you cannot have explicit control over the name of a transaction, where 'name' means the transaction name that will be shown in a transaction monitor, if applicable (for example, WebLogic’s transaction monitor), and in logging output. For declarative transactions, the transaction name is always the fully-qualified class name + "." + method name of the transactionally-advised class. For example, if the handlePayment(..) method of the BusinessService class started a transaction, the name of the transaction would be: com.foo.BusinessService.handlePayment.

Multiple Transaction Managers with @transactional

Most Spring applications only need a single transaction manager, but there may be situations where you want multiple independent transaction managers in a single application. The value attribute of the @transactional annotation can be used to optionally specify the identity of the PlatformTransactionManager to be used. This can either be the bean name or the qualifier value of the transaction manager bean. For example, using the qualifier notation, the following Java code

public class TransactionalService {

@Transactional("order")

public void setSomething(String name) { ... }

@Transactional("account")

public void doSomething() { ... }

}

could be combined with the following transaction manager bean declarations in the application context.

tx:annotation-driven/

<bean id="transactionManager1" class="org.springframework.jdbc.datasource.DataSourceTransactionManager">

...

<qualifier value="order"/>

</bean>

<bean id="transactionManager2" class="org.springframework.jdbc.datasource.DataSourceTransactionManager">

...

<qualifier value="account"/>

</bean>

In this case, the two methods on TransactionalService will run under separate transaction managers, differentiated by the "order" and "account" qualifiers. The default tx:annotation-driven target bean name transactionManager will still be used if no specifically qualified PlatformTransactionManager bean is found.

Custom shortcut annotations

If you find you are repeatedly using the same attributes with @transactional on many different methods, then Spring’s meta-annotation support allows you to define custom shortcut annotations for your specific use cases. For example, defining the following annotations

@target({ElementType.METHOD, ElementType.TYPE})

@retention(RetentionPolicy.RUNTIME)

@transactional("order")

public @interface OrderTx {

}

@target({ElementType.METHOD, ElementType.TYPE})

@retention(RetentionPolicy.RUNTIME)

@transactional("account")

public @interface AccountTx {

}

allows us to write the example from the previous section as

public class TransactionalService {

@OrderTx

public void setSomething(String name) { ... }

@AccountTx

public void doSomething() { ... }

}

Here we have used the syntax to define the transaction manager qualifier, but could also have included propagation behavior, rollback rules, timeouts etc.

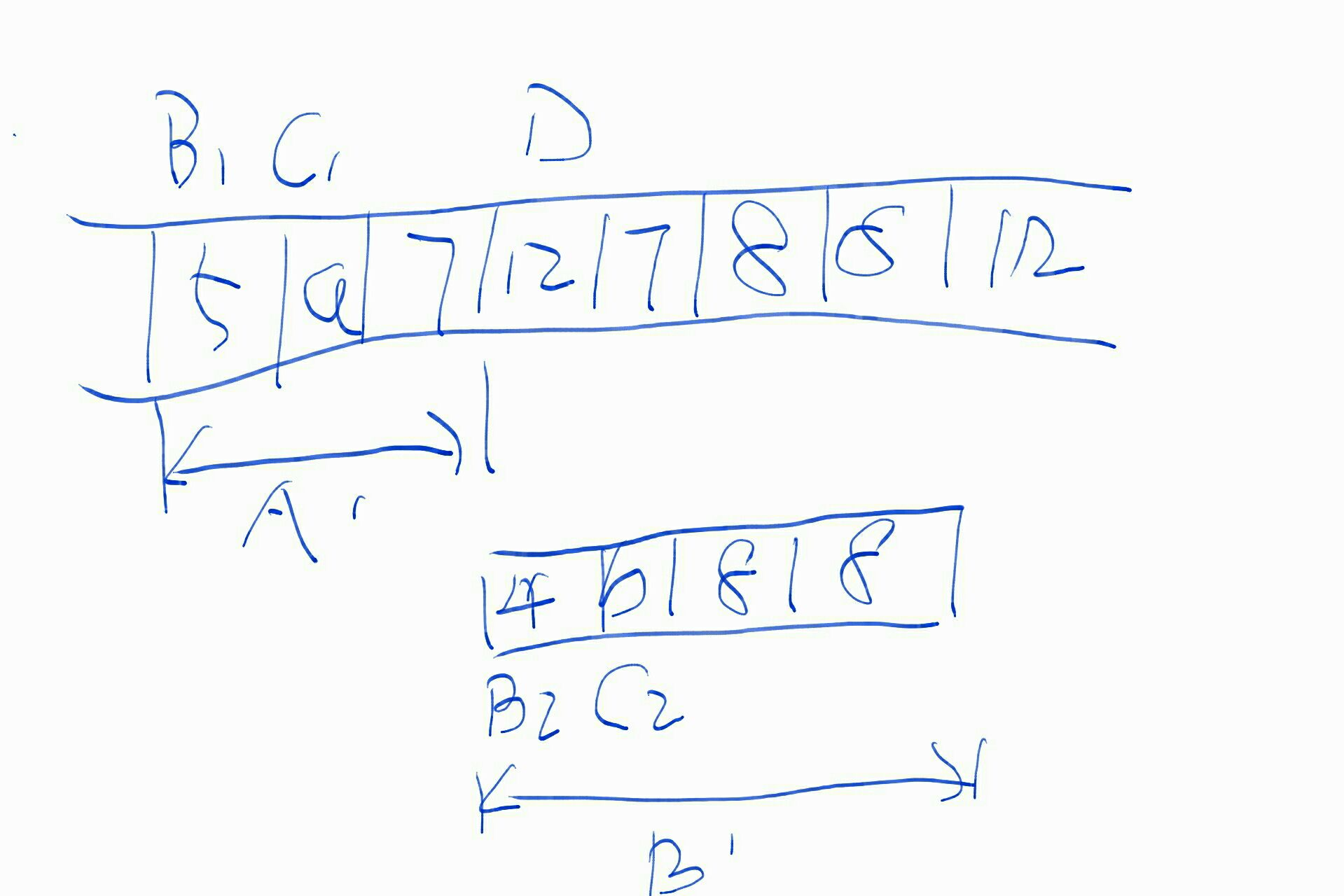

16.5.7 Transaction propagation

This section describes some semantics of transaction propagation in Spring. Please note that this section is not an introduction to transaction propagation proper; rather it details some of the semantics regarding transaction propagation in Spring.

In Spring-managed transactions, be aware of the difference between physical and logical transactions, and how the propagation setting applies to this difference.

Required

tx prop required

PROPAGATION_REQUIRED

When the propagation setting is PROPAGATION_REQUIRED, a logical transaction scope is created for each method upon which the setting is applied. Each such logical transaction scope can determine rollback-only status individually, with an outer transaction scope being logically independent from the inner transaction scope. Of course, in case of standard PROPAGATION_REQUIRED behavior, all these scopes will be mapped to the same physical transaction. So a rollback-only marker set in the inner transaction scope does affect the outer transaction’s chance to actually commit (as you would expect it to).

However, in the case where an inner transaction scope sets the rollback-only marker, the outer transaction has not decided on the rollback itself, and so the rollback (silently triggered by the inner transaction scope) is unexpected. A corresponding UnexpectedRollbackException is thrown at that point. This is expected behavior so that the caller of a transaction can never be misled to assume that a commit was performed when it really was not. So if an inner transaction (of which the outer caller is not aware) silently marks a transaction as rollback-only, the outer caller still calls commit. The outer caller needs to receive an UnexpectedRollbackException to indicate clearly that a rollback was performed instead.

RequiresNew

tx prop requires new

PROPAGATION_REQUIRES_NEW

PROPAGATION_REQUIRES_NEW, in contrast to PROPAGATION_REQUIRED, uses a completely independent transaction for each affected transaction scope. In that case, the underlying physical transactions are different and hence can commit or roll back independently, with an outer transaction not affected by an inner transaction’s rollback status.

Nested

PROPAGATION_NESTED uses a single physical transaction with multiple savepoints that it can roll back to. Such partial rollbacks allow an inner transaction scope to trigger a rollback for its scope, with the outer transaction being able to continue the physical transaction despite some operations having been rolled back. This setting is typically mapped onto JDBC savepoints, so will only work with JDBC resource transactions. See Spring’s DataSourceTransactionManager.

16.5.8 Advising transactional operations

Suppose you want to execute both transactional and some basic profiling advice. How do you effect this in the context of tx:annotation-driven/?

When you invoke the updateFoo(Foo) method, you want to see the following actions:

Configured profiling aspect starts up.

Transactional advice executes.

Method on the advised object executes.

Transaction commits.

Profiling aspect reports exact duration of the whole transactional method invocation.

[Note]

This chapter is not concerned with explaining AOP in any great detail (except as it applies to transactions). See Chapter 10, Aspect Oriented Programming with Spring for detailed coverage of the following AOP configuration and AOP in general.

Here is the code for a simple profiling aspect discussed above. The ordering of advice is controlled through the Ordered interface. For full details on advice ordering, see the section called “Advice ordering”. .

package x.y;

import org.aspectj.lang.ProceedingJoinPoint;

import org.springframework.util.StopWatch;

import org.springframework.core.Ordered;

public class SimpleProfiler implements Ordered {

private int order;

// allows us to control the ordering of advice

public int getOrder() {

return this.order;

}

public void setOrder(int order) {

this.order = order;

}

// this method is the around advice

public Object profile(ProceedingJoinPoint call) throws Throwable {

Object returnValue;

StopWatch clock = new StopWatch(getClass().getName());

try {

clock.start(call.toShortString());

returnValue = call.proceed();

} finally {

clock.stop();

System.out.println(clock.prettyPrint());

}

return returnValue;

}

}

<bean id="fooService" class="x.y.service.DefaultFooService"/>

<!-- this is the aspect -->

<bean id="profiler" class="x.y.SimpleProfiler">

<!-- execute before the transactional advice (hence the lower order number) -->

<property name="order" __value="1"__/>

</bean>

<tx:annotation-driven transaction-manager="txManager" __order="200"__/>

<aop:config>

<!-- this advice will execute around the transactional advice -->

<aop:aspect id="profilingAspect" ref="profiler">

<aop:pointcut id="serviceMethodWithReturnValue"

expression="execution(!void x.y..*Service.*(..))"/>

<aop:around method="profile" pointcut-ref="serviceMethodWithReturnValue"/>

</aop:aspect>

</aop:config>

<bean id="dataSource" class="org.apache.commons.dbcp.BasicDataSource" destroy-method="close">

<property name="driverClassName" value="oracle.jdbc.driver.OracleDriver"/>

<property name="url" value="jdbc:oracle:thin:@rj-t42:1521:elvis"/>

<property name="username" value="scott"/>

<property name="password" value="tiger"/>

</bean>

<bean id="txManager" class="org.springframework.jdbc.datasource.DataSourceTransactionManager">

<property name="dataSource" ref="dataSource"/>

</bean>

The result of the above configuration is a fooService bean that has profiling and transactional aspects applied to it in the desired order. You configure any number of additional aspects in similar fashion.

The following example effects the same setup as above, but uses the purely XML declarative approach.

<bean id="fooService" class="x.y.service.DefaultFooService"/>

<!-- the profiling advice -->

<bean id="profiler" class="x.y.SimpleProfiler">

<!-- execute before the transactional advice (hence the lower order number) -->

__<property name="order" value="1__"/>

</bean>

<aop:config>

<aop:pointcut id="entryPointMethod" expression="execution(* x.y..*Service.*(..))"/>

<!-- will execute after the profiling advice (c.f. the order attribute) -->

<aop:advisor advice-ref="txAdvice" pointcut-ref="entryPointMethod" __order="2__"/>

<!-- order value is higher than the profiling aspect -->

<aop:aspect id="profilingAspect" ref="profiler">

<aop:pointcut id="serviceMethodWithReturnValue"

expression="execution(!void x.y..*Service.*(..))"/>

<aop:around method="profile" pointcut-ref="serviceMethodWithReturnValue"/>

</aop:aspect>

</aop:config>

<tx:advice id="txAdvice" transaction-manager="txManager">

<tx:attributes>

<tx:method name="get*" read-only="true"/>

<tx:method name="*"/>

</tx:attributes>

</tx:advice>

<!-- other <bean/> definitions such as a DataSource and a PlatformTransactionManager here -->

The result of the above configuration will be a fooService bean that has profiling and transactional aspects applied to it in that order. If you want the profiling advice to execute after the transactional advice on the way in, and before the transactional advice on the way out, then you simply swap the value of the profiling aspect bean’s order property so that it is higher than the transactional advice’s order value.

You configure additional aspects in similar fashion.

16.5.9 Using @transactional with AspectJ

It is also possible to use the Spring Framework’s @transactional support outside of a Spring container by means of an AspectJ aspect. To do so, you first annotate your classes (and optionally your classes' methods) with the @transactional annotation, and then you link (weave) your application with the org.springframework.transaction.aspectj.AnnotationTransactionAspect defined in the spring-aspects.jar file. The aspect must also be configured with a transaction manager. You can of course use the Spring Framework’s IoC container to take care of dependency-injecting the aspect. The simplest way to configure the transaction management aspect is to use the tx:annotation-driven/ element and specify the mode attribute to aspectj as described in Section 16.5.6, “Using @transactional”. Because we’re focusing here on applications running outside of a Spring container, we’ll show you how to do it programmatically.

[Note]

Prior to continuing, you may want to read Section 16.5.6, “Using @transactional” and Chapter 10, Aspect Oriented Programming with Spring respectively.

// construct an appropriate transaction manager

DataSourceTransactionManager txManager = new DataSourceTransactionManager(getDataSource());

// configure the AnnotationTransactionAspect to use it; this must be done before executing any transactional methods

AnnotationTransactionAspect.aspectOf().setTransactionManager(txManager);

[Note]

When using this aspect, you must annotate the implementation class (and/or methods within that class), not the interface (if any) that the class implements. AspectJ follows Java’s rule that annotations on interfaces are not inherited.

The @transactional annotation on a class specifies the default transaction semantics for the execution of any method in the class.

The @transactional annotation on a method within the class overrides the default transaction semantics given by the class annotation (if present). Any method may be annotated, regardless of visibility.

To weave your applications with the AnnotationTransactionAspect you must either build your application with AspectJ (see the AspectJ Development Guide) or use load-time weaving. See Section 10.8.4, “Load-time weaving with AspectJ in the Spring Framework” for a discussion of load-time weaving with AspectJ.

16.6 Programmatic transaction management

The Spring Framework provides two means of programmatic transaction management:

Using the TransactionTemplate.

Using a PlatformTransactionManager implementation directly.

The Spring team generally recommends the TransactionTemplate for programmatic transaction management. The second approach is similar to using the JTA UserTransaction API, although exception handling is less cumbersome.

16.6.1 Using the TransactionTemplate

The TransactionTemplate adopts the same approach as other Spring templates such as the JdbcTemplate. It uses a callback approach, to free application code from having to do the boilerplate acquisition and release of transactional resources, and results in code that is intention driven, in that the code that is written focuses solely on what the developer wants to do.

[Note]

As you will see in the examples that follow, using the TransactionTemplate absolutely couples you to Spring’s transaction infrastructure and APIs. Whether or not programmatic transaction management is suitable for your development needs is a decision that you will have to make yourself.